装置や場所の制約を受けずスポーツの試合会場などで手軽にモーションキャプチャが可能に

2020-01-17 東京大学,株式会社 NTT ドコモ

国立大学法人東京大学 大学院情報理工学系研究科 中村仁彦研究室(以下、東京大学・中村研究室)と、株式会社NTTドコモ(以下、ドコモ)の研究チームは、東京大学・中村研究室の開発したカメラ映像だけからモーションキャプチャを行う技術「VMocap(ブイモーキャプ)※1」を応用することで、特殊な装置やスーツを用いずに、広い空間における複数人のモーションキャプチャを行う技術(以下、本技術)を開発しました。

これにより、スポーツの試合やライブ会場など、従来モーションキャプチャが困難だった場所でも手軽にモーションデータを取得し、運動解析や3Dアニメーションの作成ができるようになります。

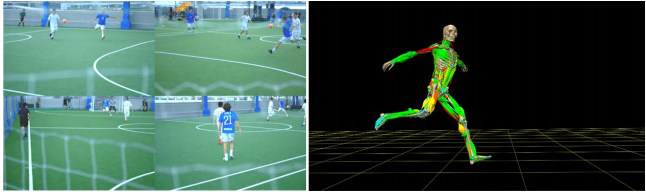

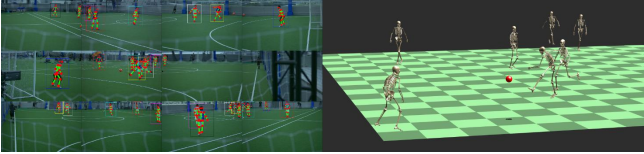

<図1>複数人ビデオモーションキャプチャのイメージ

一般的にモーションキャプチャを行うためには特殊な装置やスーツが必要で、計測場所や利用シーンが限定されています。近年では画像認識技術を応用することで特殊な機材を用いずに、カメラ映像だけからモーションキャプチャを行う技術も登場していますが、映像上における人同士の重なり合いによる解析の難しさや、背景が切り抜き易い環境でしか用いることができないといった制約が原因で、屋内・屋外、空間の広さを問わずに複数人の高精度なモーションキャプチャを行う技術は実現されていませんでした。

本技術は解析に用いるべき最適な映像を、複数のカメラから自動的に選択して切り替えることで、広い空間における複数人のモーションキャプチャを行います。また、人同士の身体が映像上で重なって見える状況下でも、人の骨格構造と運動の連続性、そして最新の画像認識技術を活用することによって頑強に運動を推定することができ、フットサルのように複数の選手が激しく動き回るようなシーンでも、高精度で滑らかなモーションデータや骨の動きが取得出来ることを実証しました。

また本技術に加え、東京大学・中村研究室がもつロボティクスに基づいた動作解析技術※2を用いることで、骨の運動だけでなく身体に働く力や筋の活動まで計算し、可視化できることを確認しました。これによって複数台のカメラ映像だけから、運動の計測・解析までが一貫して行えるようになりました。

今後は本技術を、サッカー・野球・体操・フィギュアスケートなどのスポーツに適用し、トレーニングや戦術解析、障がい予防、運動のアーカイブ化などに役立ててまいります。また、エンターテインメント領域における3Dアニメーション作成、介護・リハビリ現場での運動評価などにも活用していく予定です。

なお、2020年1月23日(木)から1月24日(金)に開催する「DOCOMOOpen House2020※3」にて本技術に関するデモ展示を行います。

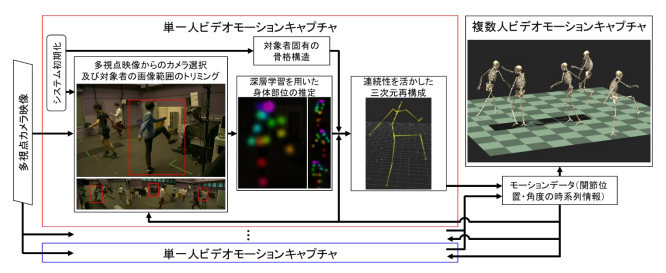

※1 深層学習によってカメラ映像における人の身体部位を推定する技術を、複数台のカメラから用いることで、3次元空間における身体部位の位置を推測し、その位置に対して骨格構造と運動の連続性に基づくフィルタ処理を施すことで、カメラ映像のみから高精度で滑らかなモーションキャプチャを行う技術のこと。

※2 身体部位の加速度をもとに算出される力や、地面やボールなど身体の接触箇所に加わる反力を元に、その力を発揮するために必要な筋の活動を算出する技術のこと。

※3 展示内容の詳細はイベントサイトをご確認ください。(http://docomo–openhouse.jp/2020/)

別紙

参考資料

<図2>本技術の概略図。解析に用いるべき最適な映像を、複数のカメラから自動的に選択して切り替えることで、映像上における各対象の身体部位を推定します。この推定を複数の視点から行いつつ、骨格構造や運動の連続性に基づくフィルタ処理を施すことで、高精度で滑らかなモーションデータを取得します。取得されたモーションデータは、次時刻の映像選択に用いられ、この一連のループが最終的なモーションキャプチャの性能に好循環をもたらし、複数人のモーションキャプチャを可能にします。

<図3>12台のカメラを用いて、フットサルの試合を行っている全選手のモーションを取得している様子。可動域まで考慮した関節角度を計算することで、骨の動きをCGとして描いている。

<図4>取得したモーションデータから、選手の筋活動をシミュレーションしている様子。CG において赤く描かれている部分が、筋が強く活動している部分を表している。

◆関連論文

Takuya Ohashi, Yosuke Ikegami, Yoshihiko Nakamura. Synergetic Reconstruction from 2D Pose and 3D Motion for Wide-Space Multi-Person Video Motion Capture in the Wild. CoRR, arXiv, 2020.