敵対的な学習により、ネットワークを欺くことが難しくなる Adversarial training makes it harder to fool the networks

2022-09-13 アメリカ・ロスアラモス国立研究所(LANL)

新しい方法は、ニューラルネットワークを比較するのに適した方法で、これは、AIの背後にある数学をより良く理解するための重要なステップである。

論文は、ネットワークの類似性を研究するだけでなく、ロバストなニューラルネットワークの挙動を特徴付けるための重要な一歩となる。

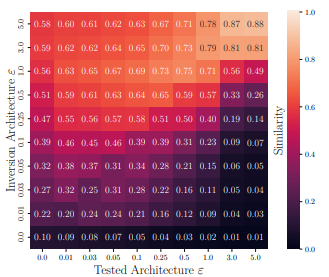

ネットワークの類似性という新しい指標を、敵対的トレーニングを受けたニューラルネットワークに適用し、敵対的トレーニングによって、コンピュータビジョン領域のニューラルネットワークは、攻撃の大きさが増すにつれて、ネットワークアーキテクチャにかかわらず、非常に似たデータ表現に収束してしまうことを発見した。

<関連情報>

一人訓練すれば、全員訓練したことになる:アーキテクチャ間の類似性はロバスト性と共に増加する If You’ve Trained One You’ve Trained Them All: Inter-Architecture Similarity Increases With Robustness

Haydn T. Jones ,Jacob M. Springer, Garrett T. Kenyon, Juston S. Moore

Accepted for the 38th Conference on Uncertainty in Artificial Intelligence (UAI 2022).

Abstract

Previous work has shown that commonly-used metrics for comparing representations between neural networks overestimate similarity due to correlations between data points. We show that intraexample feature correlations also causes significant overestimation of network similarity and propose an image inversion technique to analyze only the features used by a network. With this technique, we find that similarity across architectures is significantly lower than commonly understood, but we surprisingly find that similarity between models with different architectures increases as the adversarial robustness of the models increase. Our findings indicate that robust networks tend toward a universal set of representations, regardless of architecture, and that the robust training criterion is a strong prior constraint on the functions that can be learned by diverse modern architectures. We also find that the representations learned by a robust network of any architecture have an asymmetric overlap with non-robust networks of many architectures, indicating that the representations used by robust neural networks are highly entangled with the representations used by non-robust networks.