「人手をかけたAI」から「自ら学ぶAI」へ向けて

2018/12/17 株式会社東芝,理化学研究所

株式会社東芝(以下、東芝)と国立研究開発法人理化学研究所(以下、理研)は、深層学習によって得られるAIである「深層ニューラルネットワーク(DNN: Deep Neural Networks)」のコンパクト化技術を開発しました。本技術は、DNNの性能を維持したままで学習した結果であるパラメーターを80%削減することができ、エッジデバイス上で高精度な音声や画像などの認識処理を動作させることが可能となります。

本技術は、革新的な次世代人工知能基盤技術における研究開発成果の実用化加速のために2017年4月に設立した、理研AIP-東芝連携センターにおける成果です。東芝と理研は、本技術の詳細を、12月17日から20日に米フロリダ州で開催予定の機械学習に関する国際会議であるIEEE International Conference on Machine Learning and Applications (ICMLA) 2018にて発表します。

ニューラルネットワークは、人間の脳の生物学的な仕組みを模したAIの計算モデルあり、近年ではこのネットワークを多層構造化したDNNを用いることで、より複雑で大規模な認識処理を行うことが可能になりつつあります。深層学習によって得られるDNNは人手による処理を必要とする従来の方法よりも高精度であると言われており、音声認識、機械翻訳をはじめ、自動運転向け画像認識まで様々な用途への適用が検討されています。しかし、高い性能を実現するDNNは、大規模で複雑化する傾向があり、演算能力やメモリ量が限られたエッジデバイス上で動作させることが困難でした。このような大規模なDNNをコンパクトにする技術が複数の研究機関から提案されていますが、特別な処理や追加学習が必要となるなど、手間がかかることが課題となっていました。

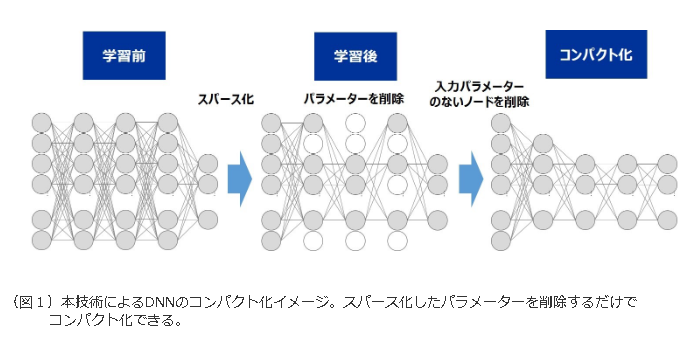

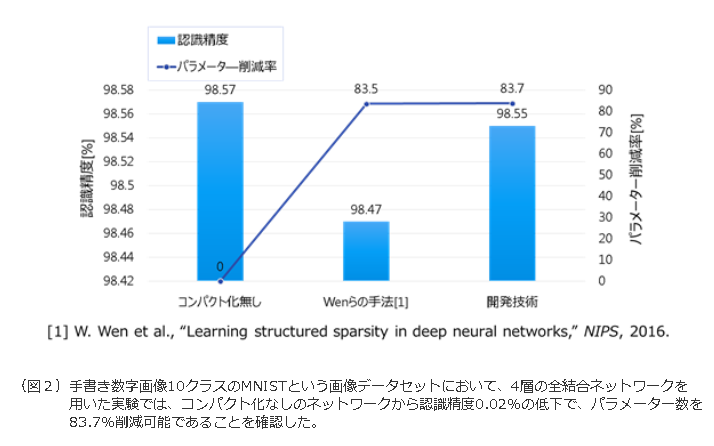

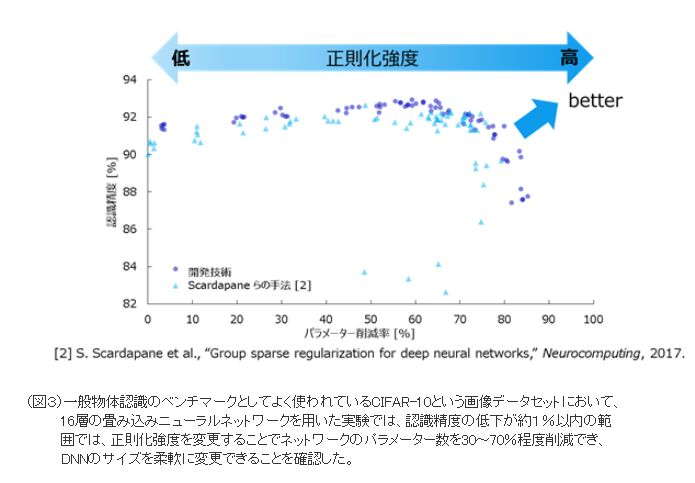

東芝は、深層学習を行う際に、DNNの一部のパラメーターが自動的にゼロ近傍に収束する「スパース化現象」を発見し、理研と共同でその発生原理を解明しました。学習後にゼロとなったパラメーターは認識結果に影響しないことから、学習後にそれらのパラメーターを削除することでDNNのコンパクト化を実現しました(図1)。公開データセットを用いた実験では、本技術が、従来技術よりも認識精度の低下を抑えつつ、約80%のパラメーターを削減できることを確認しました(図2)。さらに、パラメーター削減率を調整し、DNNのサイズを柔軟に変更できる方法を開発しました(図3)。

「スパース化現象」は、学習条件として(1)活性化関数としてReLU注1、(2)正則化関数注2としてパラメーターの二乗ノルム、(3)最適化方法としてAdam注3、を用いる場合に発生します。これらは一般的に用いられる学習条件ですが、本現象を発生させることは今まで知られていませんでした。この現象を用いることで、学習後の不要なパラメーターの削除により、従来に比べて手軽にDNNをコンパクト化できます。

東芝と理研は今後、自動運転向け画像認識システムなど様々な組み込み機器やエッジデバイスにおける高度なDNNの活用にむけて研究開発を進め、本技術の2~3年後の実用化をめざします。

注1 Rectified linear unit。DNNの表現力を高めるために一般的に導入される非線形関数。

注2 L2 Regularization function。学習データへの過剰適合を抑制するために導入される関数で、パラメーターの値を小さく抑える効果がある。正則化関数の強度が大きいほど効果が高い。

注3 Adaptive moment estimation。確率的勾配降下法と呼ばれるパラメーター最適化手法の1つ。