欧州の銀行と共同で金融分野のアプリケーションに適用し、有効性を実証

2021-03-31 株式会社富士通研究所

株式会社富士通研究所(注1)(以下、富士通研究所)は、このたび、設計段階から公平性を考慮できるAIの開発手法 Fairness by Design(フェアネス・バイ・デザイン)を開発しました。

本手法については、2020年12月から2021年3月にかけて、欧州圏有数の銀行グループであるイタリアのインテーザ・サンパオロ銀行(注2)(以下、ISP)と共同で実証実験を行い、地域ごとに異なる文化などの差異を考慮しながらローン審査AIアプリケーションにおける公平性を改善できることを示し、その有効性を実証しました。

今回開発したFairness by Designでは、設計段階からユーザーや関係者の意見を取り入れるデザイン手法として社会科学で確立されている参加型デザイン手法(注3)を用いて、例えば、ローン審査の判断基準となる収入、勤務先、取引履歴などの属性と、公平性(注4)に関わる年齢、性別、国籍などの属性の重みを数値化することで、ビジネス上の要件と公平性をバランスさせたAIモデルの開発を可能とします。さらに、公平性に関わる属性、文化やビジネス慣習の違いでは容認されない偏見を除去する手法として、年齢や性別、国籍などの属性が特定の条件で組み合わされた時に現れる交差バイアス(注5)を軽減するアルゴリズムも新たに開発し、Fairness by Designに組み込みました。

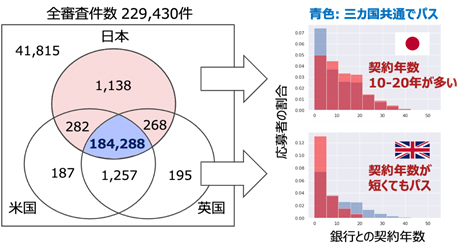

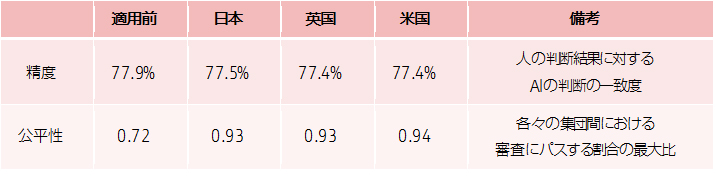

実証実験では、本手法を活用して、日本、米国、英国の3地域に対応したローン審査AIを構築し、ISPが保有する23万件のデータを用いてローン審査を行ったところ、応募者全体の約2%に対して、地域ごとの公平性により判断が異なることが明らかになりました。さらに、交差バイアスを軽減するアルゴリズムを適用したところ、審査精度は地域ごとに大きく変わることなく、公平性が大幅に改善されることが検証できました。

今後、当社は、ビジネス慣習が異なる様々な領域や文化が異なる多種多様な地域で実証実験を進め、公平なAIの開発を通じて公正で平等な社会の実現に貢献します。

開発の背景と課題

近年、AIは、技術の進展に伴い、防犯や人材マッチング、金融取引など幅広く社会システムに組み込まれ、人や社会に関わる重要な判断を支援しています。一方で、様々なデータを用いて学習した結果から、AIは統計的に確率の高い判断を下すという特性上、過去のデータに含まれているバイアス(偏見)によって不公平な判断を下す危険性が指摘されており、それを防ぐ様々な対策が提案、実装されています。

この公平性の基準は、文化やビジネス慣習などで異なる場合があり、現在、AIシステムを構築するシステム設計者がこれらの多様な公平性の基準を判断しAIに反映させています。しかし、その設定がシステムの利用環境に応じた適切な設定か否かを確認する手段がないことが大きな課題となっていました。

開発した手法

今回、AIの開発手法として、設計段階から公平性を考慮できるFairness by Designを開発しました。本手法により、様々な文化的背景やビジネス慣習を考慮した公平なAIシステムの開発が可能となります。

本開発手法の特長は以下の通りです。

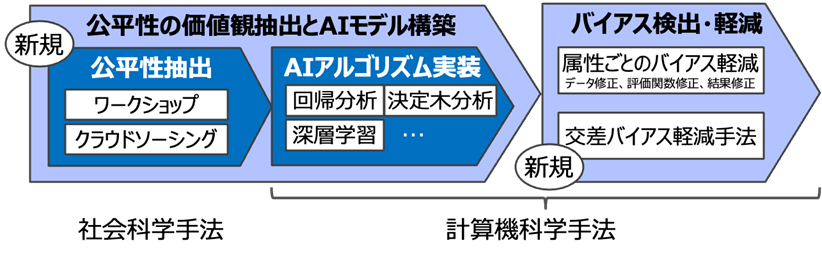

- 社会科学を用いた公平性の価値観の抽出とそのAIモデル生成

参加型デザイン手法を用いて、公平性に関わる価値観を抽出し数値化します。まず、新たに構築するAIシステムに関わる設計者や運用者、利用者などのステークホルダーを集めたワークショップを開催し、公平なAIシステムにおいて重視されるべき価値観の項目を抽出します。次に、AIシステムが利用される文化圏の不特定多数の人々の意見をクラウドソーシングにより統計的に処理し、各項目に対する価値の重みを数値化します。AIのアルゴリズムには、回帰分析(注6)や決定木分析(注7)、深層学習など従来のAIアルゴリズムを用い、それぞれの価値の重みに従ってAIモデルを生成することで、公平な価値観を取り入れたAIシステムの構築を実現します。 - バイアス(偏見)の検出および軽減

従来、AIが学習に用いるデータやアルゴリズムに潜むバイアス(偏見)を軽減する方法として、公平性に関わる性別、年齢、国籍などの一つひとつの属性に対して、各国の憲法や法規範、国際連合において採択された公平性に関する規範を参考に、データの修正や、AIアルゴリズム内部での評価関数を調整し、AIの判断結果を修正する手法が使われていました。しかし、いくつかの事例の調査から、男性、60歳以上、有色人種のように、特定の属性を組み合わせた場合に現れる交差バイアスが見過ごされ、不公平な判断が下される危険性があることが判明しました。この問題に対処するため、属性の組み合わせに対するバイアスを多角的にチェックして、精度とのバランスを考慮しつつバイアスを軽減する処理を繰り返し行うことで、交差バイアスを軽減する新たな手法を開発しました。

図1 :Fairness by Designによる設計手法のイメージ

図1 :Fairness by Designによる設計手法のイメージ

実証実験の概要

当社は、本手法をローン審査を行うAIシステムの開発に適用し、審査結果の公平性について検証を行いました。まず、ローン審査のステークホルダーに対して公平さに対する考えを出し合うワークショップを行い、日本、英国、米国のそれぞれの文化圏における特徴的な公平性の基準を抽出し、各地域向けのAIモデルをそれぞれ構築しました。これらのAIモデルに、ISPが持つ、23万件のローン審査データを適用(注8)したところ、大多数の判断は一致するものの、2%弱の応募者に対して地域によって異なる判断結果が得られました。例えば、米国、英国では、銀行との取引期間は長いが、クレジットスコアが低い応募者がローン審査をパスした例がほとんどないことに対して、日本ではそのような例があるという特徴が見られました。これは、日本の文化やビジネス慣習が反映されたものと考えられます。また、国籍によらず、ある特定の少数グループに対してローン審査が厳しい可能性があることも分かりました。この判断結果に対して、交差バイアスを軽減する手法を適用したところ、各国において判断の精度を維持しつつ、不公平性が改善できることが実証されました。

図2 ローン審査における文化圏ごとの比較と日英での契約年数による審査結果の相違

図3 交差バイアスの軽減結果

今後

富士通株式会社(注9)は、2019年3月に「富士通グループAIコミットメント」を公開し、同年9月以来、「富士通グループAI倫理外部委員会」を継続的に開催しているほか、AI倫理の社内外への浸透に向けた様々な活動をしています。

当社は、今後も、ビジネス慣習が異なる様々なビジネス領域や、文化が異なる多種多様な地域における実証実験を進め、公平なAIシステム開発の標準プロセス構築を目指します。

ISP データサイエンス&人工知能部門長 アンドレア・クラウディオ・コセンティーニ様からのコメント

富士通研究所の研究員とインテーザ・サンパオロ銀行のデータサイエンティストによって構成されたチームは、金融分野におけるAIの利用における課題の中で、特に難しいとされる公平性に関する課題を解決する手法を開発し、AIにおける人間中心のアプローチの確立という当初の目的が達成されました。引き続き、AI倫理における課題に取り組むため、継続的に連携していきたいと考えています。

AI4People 委員長 ミケランジェロ・バラッチ・ボンビチーニ様からのコメント

富士通研究所は、AI4People(注10)創立以来、主要メンバーとして大きく貢献し、欧州におけるAI倫理の発展に大きな役割を果たしてきました。今回、文化の違いを考慮したAIの公平性という重要な課題に対して初めて取り組み、新たな知見を獲得したことを大変嬉しく思います。本成果の一部は、AI4Peopleの活動の一環として欧州でのAI法制化を進めている、欧州委員会および議論をリードするAI HLEG(AIの高度専門家グループ)に対して、法制化が金融分野に与える影響の評価結果として報告いたしました。文化によって異なる公平性を考慮したAIの実現に向けて、これからも共に活動していきたいと思います。

商標について

記載されている製品名などの固有名詞は、各社の商標または登録商標です。

注釈

注1

株式会社富士通研究所:

本社 神奈川県川崎市、代表取締役社長 原 裕貴。

注2

インテーザ・サンパオロ銀行:

本社 イタリア・トリノ、CEO Carlo Messina。

注3

参加型デザイン手法:

エンドユーザーや関係者が製品、サービスの設計の段階に参画し、議論することで、ニーズに合致しているか、社会的要請にマッチしているかを確認しつつ設計を行う手法。

注4

公平性:

世界人権宣言や各国の憲法・法律、SDGsで不平等が許されないとされる項目。性別、年齢、国籍などを含む。

注5

交差バイアス:

特定の属性の組み合わせにより、大きな差別が生じる現象。例えば、シングル・マザーに対する差が、性別、婚姻状況、子供の有無のそれぞれで想定される差別よりも大きく現れる現象。

注6

回帰分析:

データを用いて変数間の関係を表す数式を求める手法。

注7

決定木分析:

場合分けを繰り返し適用することで、条件が満たされた時に何が起こるかを示す樹形図を用いてデータを分析する手法。

注8

23万件のローン審査データを適用:

本実験では、欧州一般データ保護規則(GDPR)に則り、日本側では擬似サンプルデータを用いてアルゴリズム開発を実施し、欧州拠点にてアルゴリズムの適用を行なっています。欧州内のデータについても、適切な匿名化が施されており、プライバシー情報は含まれていません。

注9

富士通株式会社:

本社 東京都港区、代表取締役社長 時田 隆仁。

注10

AI4People:

2017年11月に、Atomium-European Institute for Science, Media and Democracyにより設立された、「よきAI社会」を作るための倫理的フレームワークを議論する有識者会議。

本件に関するお問い合わせ

株式会社富士通研究所

人工知能研究所