2021-10-20 アメリカ合衆国・マサチューセッツ工科大学(MIT)

・ MIT が、四足歩行ロボットの挙動速度と敏捷性を向上させる新システムを開発。

・ チータ等の動物に着想した四足ロボット開発は近年飛躍的な進展を遂げているが、急激な高低差のある土地での歩行能力に課題がある。視覚機能を付与する既存の技術のほとんどは、機敏なロボティックシステムに適していない。

・ 新システムは、ロボット最前部搭載のビデオカメラによるリアルタイムの情報を処理するコントローラと、その情報をロボットの身体の動作の指示に変換するコントローラの 2 種類の制御システムから構成される。

・ コントローラとは、ロボットの状態を一連のアクションに変換するアルゴリズムのこと。視覚機能を含まないブラインド・コントローラは効果的だが、高低差のない平坦な土地でのロボットの歩行にのみ有効。視覚機能を含むシステムでは土地のハイトマップ(高さマップ)を利用するが、その構築プロセスは緩慢な上、マップに不備があると機能が停止し易くなる。

・ 新システムは、ブラインド・コントローラの最も優れた要素とリアルタイムで視覚情報を処理するモジュールを組み合わせたもの。ロボットのカメラが目前に広がる土地の距離画像を撮影し、それをロボットの身体情報(関節の角度や身体の向き等)と共にニューラルネットワークの上位コントローラへ送信する。上位コントローラは、数百種類の土地を走行するロボットシミュレーションの強化学習による訓練を通じ、報酬を得た最も好結果の挙動を学習する。

・ 同ニューラルネットワークが目的の軌道を出力すると、下位コントローラがその情報を受け、ロボットの挙動を表す物理方程式によりロボットの 12 個の各関節のトルクを決定する。下位コントーラの利用を含むこのような階層的制御のフレームワークにより、ロボットの挙動を向上させる制御が可能に。

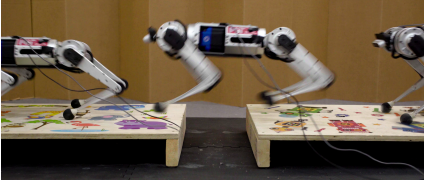

・ 隙間を設けて配置した木製の歩み板の上での MIT のミニチータの歩行実証では、歩み板の 90%で隙間を飛び越えた歩行に成功。人間が速度を蓄え両足に力を込めて大きな隙間を飛び越えるように、ミニチータは脚が接地するタイミングと長さを調整して移動できた。

・ 今後の予定は、オンボードでの全計算を可能にするより強力なコンピューターの搭載、モーションキャプチャシステムの排除と上位・下位各コントローラの向上。

・ 本研究は、MIT の Improbable AI Lab、Biomimetic Robotics Laboratory、NAVER LABS およびDARPA Machine Common Sense Program が一部支援した。

URL: https://news.mit.edu/2021/one-giant-leap-mini-cheetah-1020

<NEDO海外技術情報より>

(関連情報)

関連論文(フルテキスト)

Learning to Jump from Pixels

URL: https://openreview.net/pdf?id=R4E8wTUtxdl

Abstract

Today’s robotic quadruped systems can robustly walk over a diverse range of rough but continuous terrains, where the terrain elevation varies gradually. Locomotion on discontinuous terrains, such as those with gaps or obstacles, presents a complementary set of challenges. In discontinuous settings, it becomes necessary to plan ahead using visual inputs and to execute agile behaviors beyond robust walking, such as jumps. Such dynamic motion results in significant motion of onboard sensors, which introduces a new set of challenges for real-time visual processing. The requirement for agility and terrain awareness in this setting reinforces the need for robust control. We present Depth-based Impulse Control (DIC), a method for synthesizing highly agile visually-guided locomotion behaviors. DIC affords the flexibility of model-free learning but regularizes behavior through explicit model-based optimization of ground reaction forces. We evaluate the proposed method both in simulation and in the real world.

.