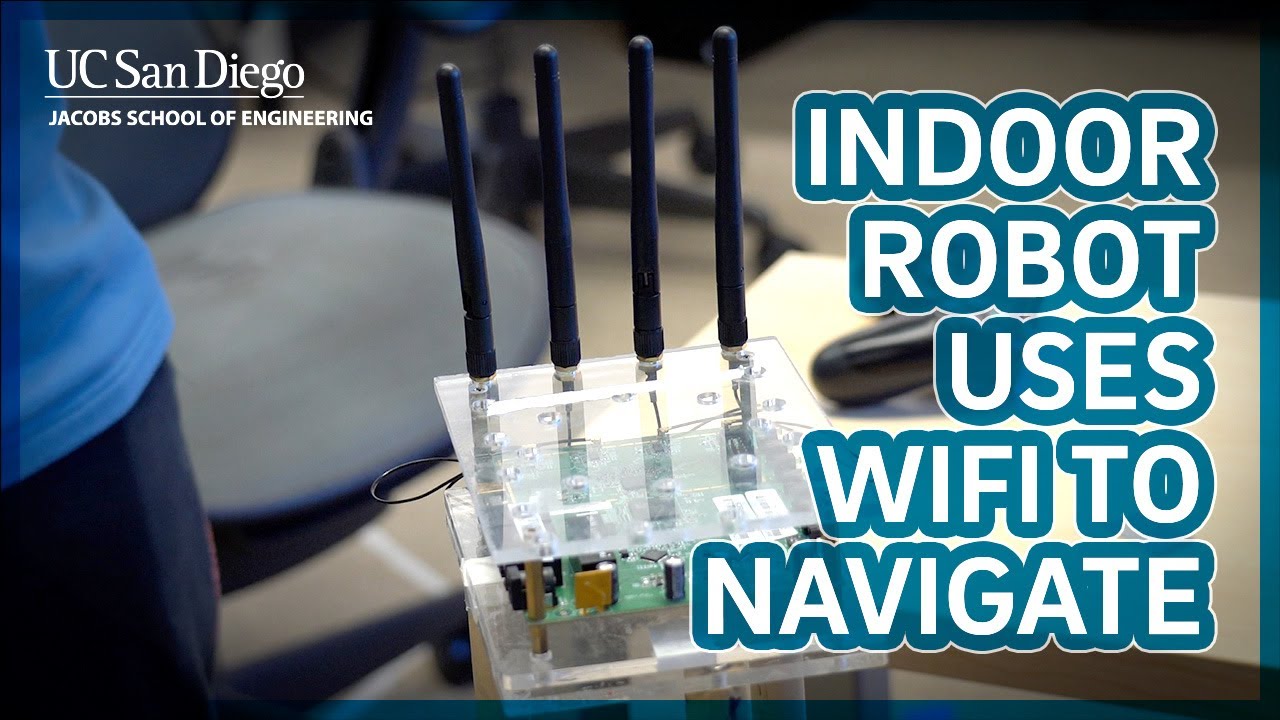

2022-05-20 アメリカ合衆国・カリフォルニア大学サンディエゴ校(UCSD)

・ UCSD が、WiFi 信号を利用して屋内でのロボットの移動経路を正確にマッピングする、低コスト・省エネのロボットナビゲーション技術を開発。

・ ロボットナビゲーションシステムのほとんどが、カメラや LiDARs 等の光センサーを利用している。新技術では、開発した WiFi センサーと WiFi アクセスポイント間での距離情報や角度情報を持つ双方向無線通信を活用する。

・ 新技術の WiFi センサーは、あらゆる場所に飛び交う無線信号で作動し、カメラや LiDARs の作動が困難となる微弱や変化する照明下や長い廊下・倉庫等の目印となるオブジェクトが繰り返し存在し解析に誤りが生じ易い場所でも機能する。特に、高価でエネルギーを大量に消費する LiDARs の低コストな代替技術を提供する。

・ 市販の WiFi トランシーバーを利用して WiFi センサーのプロトタイプを作製。ロボットに搭載した WiFi セ

ンサーは、ロボットが動き始めると WiFi アクセスポイントを呼び出してロボットの位置とアクセスポイントを認識し、WiFi アクセスポイントとの間で無線信号を継続的に送受信する。

・ 無線信号にはアクセスポイントへの到達角度やダイレクトパスの距離等の物理情報が含まれ、WiFiセンサーのアルゴリズムがそれらを抽出・計算し、ロボットとアクセスポイントの位置や移動方向をマッピングする。

・ オフィスビルのフロアに複数のアクセスポイントを配置し、性能比較のためロボットに WiFi センサー、カメラと LiDARs を搭載してフロアを移動させる試験を実施。その結果、WiFi センサーによる位置の特定とマッピングの精度が市販のカメラや LiDARs と同等であることを確認した。

・ 基本的に無料の WiFi 信号を利用する WiFi センシングは、視覚的な課題のある環境下でも信頼性が高く安定したセンサー機能を提供する。高価な LiDARs の代替や、カメラ等の低コストセンサーの補完が期待できる。

・ 今後は精度と安定性を提供する WiFi センサーと、環境の視覚・背景情報を提供するカメラを組み合わせた、より完全で安価なマッピング技術の開発に取り組む。

URL: https://jacobsschool.ucsd.edu/news/release/3452

<NEDO海外技術情報より>

関連情報

IEEE Robotics and Automation Letters 掲載論文(アブストラクトのみ:全文は有料)

P2SLAM: Bearing Based WiFi SLAM for Indoor Robots

URL: https://ieeexplore.ieee.org/document/9691786

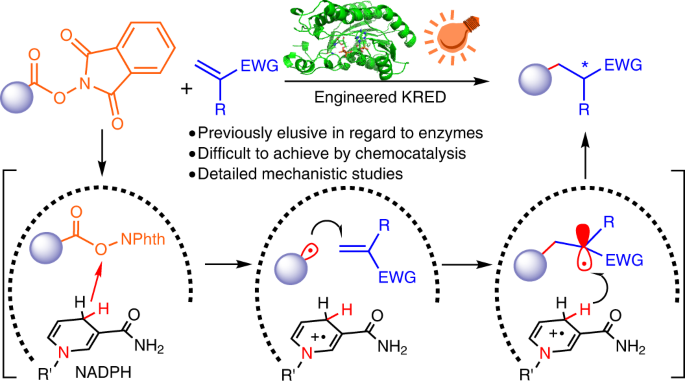

Abstract

A recent spur of interest in indoor robotics has increased the importance of robust simultaneous localization and mapping algorithms in indoor scenarios. This robustness is typically provided by the use of multiple sensors which can correct each others’ deficiencies. In this vein, exteroceptive sensors, like cameras and LiDAR’s, employed for fusion are capable of correcting the drifts accumulated by wheel odometry or inertial measurement units (IMU’s). However, these exteroceptive sensors are deficient in highly structured environments and dynamic lighting conditions. This letter will present WiFi as a robust and straightforward sensing modality capable of circumventing these issues. Specifically, we make three contributions. First, we will understand the necessary features to be extracted from WiFi signals. Second, we characterize the quality of these measurements. Third, we integrate these features with odometry into a state-of-art GraphSLAM backend. We present our results in a 25×30 m and 50×40 environment and robustly test the system by driving the robot a cumulative distance of over 1225 m in these two environments. We show an improvement of at least 6× compared odometry-only estimation and perform on par with one of the state-of-the-art Visual-based SLAM.