2019/9/10 アメリカ合衆国アルゴンヌ国立研究所(ANL)

・ ANL が、ガソリン車についてエンジン性能・燃費の向上や排出ガス量の低減を目的とする、ディープラーニング(DL)をベースとしたツール、「MaLTESE(Machine Learning Tool for Engine Simulations and Experiments)」を開発。

・ 日常的な交通手段である乗用車では、加速や減速、急速停止、さらに個人の運転習癖、道路や気候条件がエンジン性能や燃費に影響を及ぼす。

・ このような課題への対処が期待されている自動車メーカーは、多様な条件への対応策を常に講じているが、燃費と排ガスに関わるパラメータは 20 超にわたり、適正なアプローチの特定には時間とコストがかかる。

・ 同ツールの開発には、米国エネルギー省(DOE)のユーザー施設である Argonne Leadership Computing Facility (ALCF)のスーパーコンピューターの Theta を利用。自動運転やクラウド・コネクテッド車をも視野に入れているが、まずは新しいタイプのリアルタイム適応学習と制御を目的に、高性能コンピューティング(HPC)と機械学習を組合せた、メーカー仕様に近いオンボードシステムの開発を目指す。

・ 同ツールを使用して、25,000 台の車両について 25 分間の標準的な運転サイクル(シカゴの主要な 4 本の高速道路におけるラッシュアワー時の交通状況)をシミュレートし、多岐にわたる運転・エンジン駆動条件がエンジン性能と排出ガスに及ぼす影響を調査した。

・ 同シミュレーションは、ALCF の Theta システムをほぼフル稼働することで、実際の運転時間より短時間の約 15 分で完了。通常、1 エンジンサイクルの HiFi シミュレーションには、大規模なスーパーコンピューターでも数日間が必要。一般的な運転サイクルや通勤には、数千もの多様なエンジンサイクルが含まれる。

・ ANL では、過去にリアルタイム・エンジンシミュレータの「pMODES(parallel Multi-fuel Otto Diesel Engine Simulator)を開発している。従来のエンジンモデリングツールを上回る高速稼働で数千運転サイクルの性能と排出ガスを同時に処理する。同シミュレータは、2015 年に IDC research(現 Hyperion research)の HPC Innovation Award を受賞。「MaLTESE」は、同シミュレータとシミュレーション主導型 DL ツールを融合したもの。

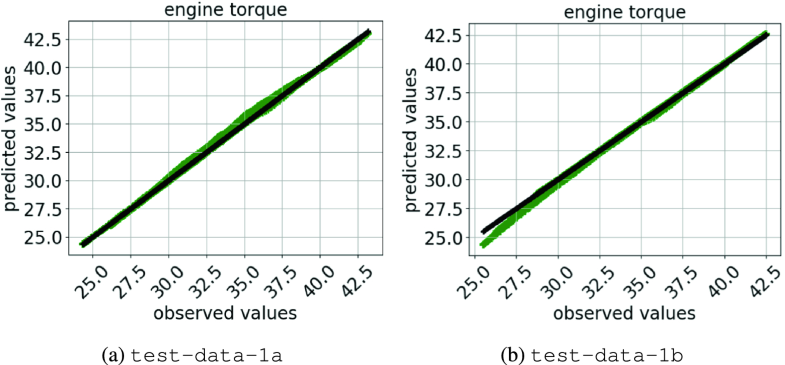

・ ディープ・ニューラルネットワーク(DNN)の訓練には「pMODES」のエンジン・シミュレーションアウトプットを使用し、運転条件やエンジン・トランスミッションの設計が及ぼす影響を DNN に学習させた。訓練済みの DNN は、一連のインプットにより数マイクロ秒でエンジン性能と排出ガス量を予測。リアルタイムのオンボード適応制御を可能にする。

・ 「MaLTESE」は、エンジン性能や車輌のダイナミクス等の重要な情報をリアルタイムでシミュレート・学習する破壊的な技術となる可能性を有し、自動運転車やコネクテッド車への多大な影響と共に、自動車の設計、最適化とリアルタイム制御での HPC 利用における急速なパラダイムシフトが期待される。

・ 本研究は、DOE 科学局の Advanced Scientific Computing Research プログラムが資金を提供する、 2018 Early Career Award が一部支援した。

URL: https://www.anl.gov/article/ai-to-help-drive-engine-efficiencies-on-the-road

(関連情報)

Scientific Reports 掲載論文(フルテキスト)

MaLTESE: Large-Scale Simulation-Driven Machine Learning for Transient Driving Cycles

URL: https://link.springer.com/chapter/10.1007%2F978-3-030-20656-7_10

<NEDO海外技術情報より>

Abstract

Optimal engine operation during a transient driving cycle is the key to achieving greater fuel economy, engine efficiency, and reduced emissions. In order to achieve continuously optimal engine operation, engine calibration methods use a combination of static correlations obtained from dynamometer tests for steady-state operating points and road and/or track performance data. As the parameter space of control variables, design variable constraints, and objective functions increases, the cost and duration for optimal calibration become prohibitively large. In order to reduce the number of dynamometer tests required for calibrating modern engines, a large-scale simulation-driven machine learning approach is presented in this work. A parallel, fast, robust, physics-based reduced-order engine simulator is used to obtain performance and emission characteristics of engines over a wide range of control parameters under various transient driving conditions (drive cycles). We scale the simulation up to 3,906 nodes of the Theta supercomputer at the Argonne Leadership Computing Facility to generate data required to train a machine learning model. The trained model is then used to predict various engine parameters of interest, and the results are compared with those predicted by the engine simulator. Our results show that a deep-neural-network-based surrogate model achieves high accuracy: Pearson product-moment correlation values larger than 0.99 and mean absolute percentage error within 1.07% for various engine parameters such as exhaust temperature, exhaust pressure, nitric oxide, and engine torque. Once trained, the deep-neural-network-based surrogate model is fast for inference: it requires about 16 μ<?XML:NAMESPACE PREFIX = “[default] http://www.w3.org/1998/Math/MathML” NS = “http://www.w3.org/1998/Math/MathML” />μs for predicting the engine performance and emissions for a single design configuration compared with about 0.5 s per configuration with the engine simulator. Moreover, we demonstrate that transfer learning and retraining can be leveraged to incrementally retrain the surrogate model to cope with new configurations that fall outside the training data space.

Keywords

Transient driving cycle modeling,Surrogate modeling,Machine learning,Deep learning Deep neural networks