オンライン学習・営業活動など参加者の集中状態を定量化

2021-03-01 株式会社富士通研究所

株式会社富士通研究所(注1)(以下、富士通研究所)は、人が様々なタスクを実行している時の集中度を、表情筋の動きの変化から、集中時、非集中時の顔面の状態の違いとして検出することで高精度に捉え、定量化できる集中度推定AIモデルを新たに開発しました。

従来、AIを活用して集中度を定量化するモデルは、e-learningなど特定のタスクを実行している人の表情や振る舞いを学習することにより作成していました。しかし、表情や振る舞いは、従事するタスクや人がそれぞれに育った文化的背景に依存して異なるため、作成したモデルは個別のモデルとならざるを得ず、様々な場面に応じて個別にAIモデルを開発しなければならないことが課題でした。

今回、当社は、表情筋に対応した顔面の各部位の動作単位であるAction Unit(注2)を世界一の精度で検出する独自の技術(注3)を活用して、口元に力が入るなど数秒程度の短期間の変化や、目を凝らして一心不乱に見つめているなど数十秒にわたる長期間の変化をAction Unitごとに最適化された時間単位で捉えることで、集中、非集中状態の違いを、それぞれの文化的背景の影響を受けにくい共通の特徴として抽出することに成功しました。さらに、タスク固有の振る舞いが生じないように設計された探索や記憶を行う課題を、日本に加え、多様な地域の人のデータ収集が可能な米国および中国の延べ650人で実施し、機械学習用のデータセットとして構築することで、特定のタスクに依存しない、汎用的な集中度推定AIモデルを開発しました。この集中状態のデータセットを用いて本モデルの有効性を検証したところ、85%を超える高い精度で集中度を定量的に推定できることを確認しました。

本技術により、コロナ禍でグローバルに利用が拡大するオンラインの授業や営業活動などの各種オンラインサービスにおいて、デジタル化された参加者の集中状態のデータを活用したAIの支援により、オンラインで取り組む人のタスクや業務の効率化、生産性の向上が可能になります。

開発の背景

近年、ニューノーマルな社会において、教育や企業の現場では、授業や会議、営業活動など、様々な場面でのオンライン化が急速かつグローバルに拡大しています。

従来、対面の場では、集中を欠いた生徒への声掛けや、上の空で聞いている相手への話題転換といった、相手の集中力を引き戻すサポートが行われていましたが、オンラインの場では、離れた場所にいる相手の様子を把握することは難しく、これまで行われていた適切なサポートが困難となっています。特に、作業に対する集中度は、パフォーマンスを左右する重要な要素であり、オンラインで取り組むタスクや業務の生産性向上の手段として、集中力の維持と向上を図る適切な支援が行えるよう、集中状態を定量的に推定できるAIモデルの開発が期待されています。

課題

AIで集中度を推定する一般的な方法として、人の表情や振る舞いから予測する方法がありますが、人の表情は、それぞれが育った文化的背景により違いがあると言われており、振る舞いは、e-learningなど特定のタスクに大きく依存します。そのため、この方法では、タスクや対象とする人の文化的背景に特化した学習が行われるため、それらが変わるごとに個別にAIモデルを開発する必要がありました。

また、人が集中してタスクを実行しているときは、顔が強張る、目を凝らすなど顔面の状態に微小な変化が生じます。これらの変化は、人類共通に適用できる概念として提唱されているAction Unitを活用することで、原理的には振る舞いや文化的背景の違いによらず検出できます。しかし、集中時、非集中時の微小な顔面状態の違いをカメラで撮影した顔の動画データから捉えようとすると、例えば、Action Unitの動きで出来たしわと年齢によるしわとの区別が必要になるなど、Action Unit自体の精度の向上が課題となります。

開発した技術

今回、当社は、Action Unitを世界一の精度で検出する独自の技術を活用して、特定のタスクや文化的背景に依存せずに、人の集中度を定量化できるAIモデルを開発しました。

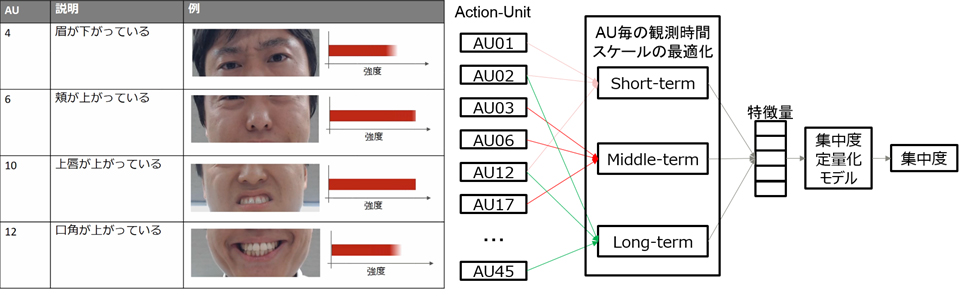

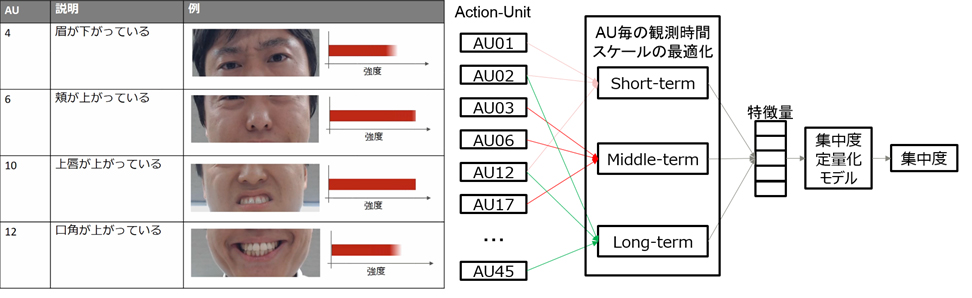

表情筋の動きの強さが異なるペア画像を学習させる方式で、表情筋の相対的な変化を的確に学習させる独自のAction Unit検出技術を活用し、口元に力が入るなど数秒程度の短期間の変化や、目を凝らして一心不乱に見つめているなど数十秒にわたる長期間の変化をAction Unitごとに最適化された時間単位で捉えます。そして、統合的に集中度を推定する新たな方式により、文化的背景に依存しない高精度な集中度推定AIモデルを開発しました(図1)。

さらに、人の集中状態の教師データを収集する際に、タスク固有の振る舞いが生じないように設計された探索や記憶を行う課題などの作業を、日米中の延べ650人で実施した結果をデータセットとして構築し、本データセットを用いて学習させることにより、特定のタスクに依存しない、汎用的な集中度推定AIモデルの作成に成功しました。

図1 集中状態に現れる人共通の特徴抽出による集中度推定方式

図1 集中状態に現れる人共通の特徴抽出による集中度推定方式

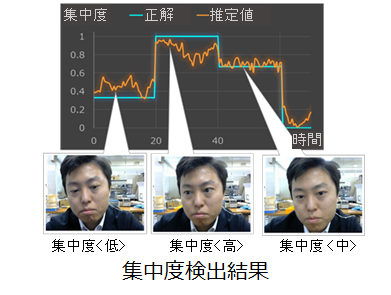

本AIモデルにより、e-learningでの集中度やデスクワークへの没入状態、工場の組み立て作業の集中度合いなど、様々なタスクにおける集中、非集中の状態を、0.0(非集中)~1.0(集中度最高)の数値で定量的に示すことができます(図2)。

図2 集中度の推定結果の例

効果

AIモデルの汎用性を検証するために、日本に加え、多様な地域のデータ収集が可能な米国および中国において、延べ650人の検証用データセットを構築しました。今回開発した集中度を推定するAIモデルを用いて、各国の被験者の集中度を推定したところ、いずれも85%以上の精度で集中度を推定することができました。この結果は、e-learningに対する生徒の集中度合いを定量化する最新の国際学会の結果と比較しても、同等以上の高い精度を実現しており、本方式が文化的背景の違いに対して有効に機能していることを確認しました。

また、開発したAIモデルを、ドライブシミュレーターによる運転の様子を収録した、集中状態と眠気による非集中状態が混在するデータで推定したところ、NEDO眠気指標(注4)に基づいてラベル付けした正解データに対して高い相関を示し、眠気による集中度低下を推定できていることが確認できました。これにより、本AIモデルが学習を行っていない異なるタスクへも適用可能なことを確認しました。

今後

今後、当社は、ニューノーマルな社会においてグローバルに拡大するオンライン授業やオンライン会議、営業活動などの様々なサービスへの本技術の適用拡大に向けて、AI倫理の観点も踏まえて検証をさらに進めるとともに、AI集中度推定モデルの実用化を目指し実証を進めます。

商標について

記載されている製品名などの固有名詞は、各社の商標または登録商標です。

注釈

注1

株式会社富士通研究所:

本社 神奈川県川崎市、代表取締役社長 原 裕貴。

注2

Action Unit:

解剖学的知見に基づいて提唱された Facial Action Coding Systemの中で定義されている約40種の表情筋に対応した顔面の各部位の動作単位。各Action Unit は、表情筋の動きに対応付けて、5段階の強度で定義される。

注3

Action Unitを世界一の精度で検出する独自の技術:

IEEE International Conference on Automatic Face & Gesture Recognition(FG 2020)において開催されたAction Unit 検出精度を競うコンペティションにおいて1位を獲得したAction Unit認識技術。

注4

NEDO眠気指標:

複数人の観察により、対象となる人の眠気を評価する指標。眠気のレベルは5段階で定義されている。

本件に関するお問い合わせ

株式会社富士通研究所

人工知能研究所