2024-01-04 アメリカ合衆国・国立標準技術研究所(NIST)

・ NIST が、敵対的攻撃(adversary attacks)に対する AI や機械学習(ML)の脆弱性を特定し、その対処・軽減方法を提案する報告書を発表。

・ 産学官の協力による研究成果で、AI 開発者やユーザーによる敵対的攻撃への対処の支援と敵対攻撃軽減のアプローチを提供する。NIST による信頼できる AI 開発支援の一環として、NIST の AI リスク管理フレームワークの運用を促進するもの。

・ あらゆる種類の AI システムへの敵対攻撃のテクニックと方法論の全体像を提供し、文献で報告されている現行の攻撃軽減戦略についても言及。現行の防御方法ではリスクの完全な軽減効果が確証されていないため、コミュニティーからのより効果的な防御策の発案を奨励している。

・ 現代社会に浸透する AI システムは、自動運転、医師の診断支援、オンラインチャットボットとして顧客とのやり取りまで様々な分野で利用されている。これらのタスクを学習するために、膨大な量のデータを使用して AI を訓練する。

・ 例えば、自動運転では高速道路や道路標識の画像データで、また、大規模言語モデル(LLM) ベースのチャットボットにはオンライン会話のデータを学習させる。これらのデータは、特定の状況における AIによる対応の予測に役立つ。

・ ただし、データソースにはウェブサイトや一般人とのやり取りが含まれ、データの信頼性が大きな課題の一つとなる。AI の訓練中・訓練後に悪意のある攻撃者がデータを破壊することで、チャットボットが悪口や人種差別的な言葉による応答を学習してしまう。AI 訓練データセットはあまりにも膨大で人間が適切に監視・選別することができなため、AI を誤認から保護する確実な方法はまだ存在しない。

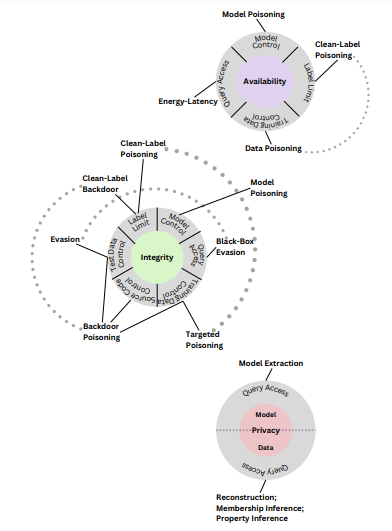

・ 本報告書では、回避、ポイズニング、プライバシー、悪用の 4 種類の敵対攻撃を設定し、攻撃者の目標、目的、能力、知識といった複数の基準で分類。これらの敵対攻撃の多くは最低限の AI の知識や攻撃能力での実行が可能。例えばポイズニング攻撃は、訓練セット全体のうちの僅か数十個の訓練サンプルの制御で実行される。

・ 敵対攻撃に対する現行の防御方法には限界があることを、AI 開発者・組織が認識することが重要。AI は著しい進歩を遂げているが、AI アルゴリズムの安全性確保には未解決の問題があり、攻撃に対して脆弱なため、悲惨な結果を招く大きな失敗を引き起こす可能性がある。

URL: https://www.nist.gov/news-events/news/2024/01/nist-identifies-types-cyberattacks-manipulate-behavior-ai-systems

<NEDO海外技術情報より>

関連情報

NIST Information Technology Laboratory

Computer Security Resource Center 発表論文(フルテキスト)

Adversarial Machine Learning: A Taxonomy and Terminology of Attacks and Mitigations

URL: https://nvlpubs.nist.gov/nistpubs/ai/NIST.AI.100-2e2023.pdf