2023-09-11 ロスアラモス国立研究所(LANL)

◆このアルゴリズムは、オークリッジ国立研究所のスーパーコンピュータSummitでのテストラン中に、巨大データセットの因子分解に関する世界記録を樹立しました。この非常にスケーラブルなアルゴリズムは、がん研究、衛星画像、ソーシャルメディアネットワーク、国家安全保障科学、地震研究など、データ豊富なアプリケーションで情報処理を妨げるハードウェアのボトルネックを解決します。

<関連情報>

- https://discover.lanl.gov/news/0911-machine-learning/

- https://link.springer.com/article/10.1007/s11227-023-05587-4

CPU/GPUアーキテクチャ上の分散型メモリ外NMF Distributed out-of-memory NMF on CPU/GPU architectures

Ismael Boureima,Manish Bhattarai,Maksim Eren,Erik Skau,Philip Romero,Stephan Eidenbenz & Boian Alexandrov

The Journal of Supercomputing Published:08 September 2023

DOI:https://doi.org/10.1007/s11227-023-05587-4

Abstract

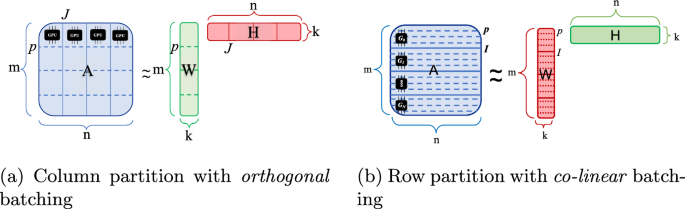

We propose an efficient distributed out-of-memory implementation of the non-negative matrix factorization (NMF) algorithm for heterogeneous high-performance-computing systems. The proposed implementation is based on prior work on NMFk, which can perform automatic model selection and extract latent variables and patterns from data. In this work, we extend NMFk by adding support for dense and sparse matrix operation on multi-node, multi-GPU systems. The resulting algorithm is optimized for out-of-memory problems where the memory required to factorize a given matrix is greater than the available GPU memory. Memory complexity is reduced by batching/tiling strategies, and sparse and dense matrix operations are significantly accelerated with GPU cores (or tensor cores when available). Input/output latency associated with batch copies between host and device is hidden using CUDA streams to overlap data transfers and compute asynchronously, and latency associated with collective communications (both intra-node and inter-node) is reduced using optimized NVIDIA Collective Communication Library (NCCL) based communicators. Benchmark results show significant improvement, from 32X to 76x speedup, with the new implementation using GPUs over the CPU-based NMFk. Good weak scaling was demonstrated on up to 4096 multi-GPU cluster nodes with approximately 25,000 GPUs when decomposing a dense 340 Terabyte-size matrix and an 11 Exabyte-size sparse matrix of density 10−6<?XML:NAMESPACE PREFIX = “[default] http://www.w3.org/1998/Math/MathML” NS = “http://www.w3.org/1998/Math/MathML” />10−6.