2023-07-26 マサチューセッツ工科大学(MIT)

◆この技術は、滑りやすい道路状況を克服してスキッドを回避したり、宇宙空間でさまざまな物体を牽引したり、強風にさらされながらもスキーヤーを追跡したりする自律型車両やドローンに活用できます。

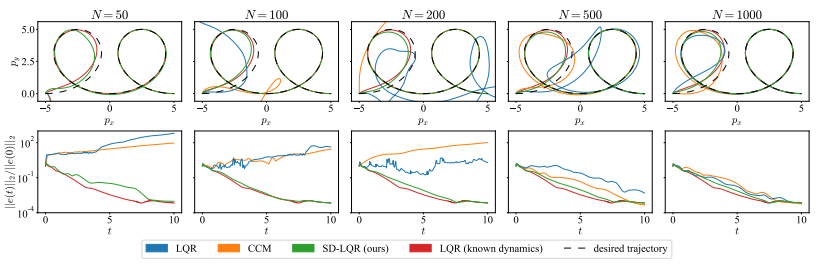

◆研究者は制御理論の構造を機械学習モデルに組み込むことで、複雑な動態を効果的に制御する方法を提案しました。このアプローチにより、効果的なコントローラを学習する際のデータ量が少なくて済み、急激な環境変化に対して高い性能を発揮することが可能となります。今後は、物理的に解釈可能なモデルの開発にも取り組む予定です。

<関連情報>

- https://news.mit.edu/2023/simpler-method-learning-control-robot-0726

- https://arxiv.org/pdf/2302.02529.pdf

データから制御指向の力学的構造を学習する Learning Control-Oriented Dynamical Structure from Data

Spencer M. Richards, Jean-Jacques Slotine, Navid Azizan, Marco Pavone

arxiv Published:24 Jun 2023

DOI:https://arxiv.org/pdf/2302.02529.pdf

Abstract

Even for known nonlinear dynamical systems, feedback controller synthesis is a difficult problem that often requires leveraging the particular structure of the dynamics to induce a stable closed-loop system. For general nonlinear models, including those fit to data, there may not be enough known structure to reliably synthesize a stabilizing feedback controller. In this paper, we discuss a state-dependent nonlinear tracking controller formulation based on a state-dependent Riccati equation for general nonlinear controlaffine systems. This formulation depends on a nonlinear factorization of the system of vector fields defining the control-affine dynamics, which always exists under mild smoothness assumptions. We propose a method for learning this factorization from a finite set of data. On a variety of simulated nonlinear dynamical systems, we empirically demonstrate the efficacy of learned versions of this controller in stable trajectory tracking. Alongside our learning method, we evaluate recent ideas in jointly learning a controller and stabilizability certificate for known dynamical systems; we show experimentally that such methods can be frail in comparison.