2023-09-21 アメリカ合衆国・ワシントン大学(UW)

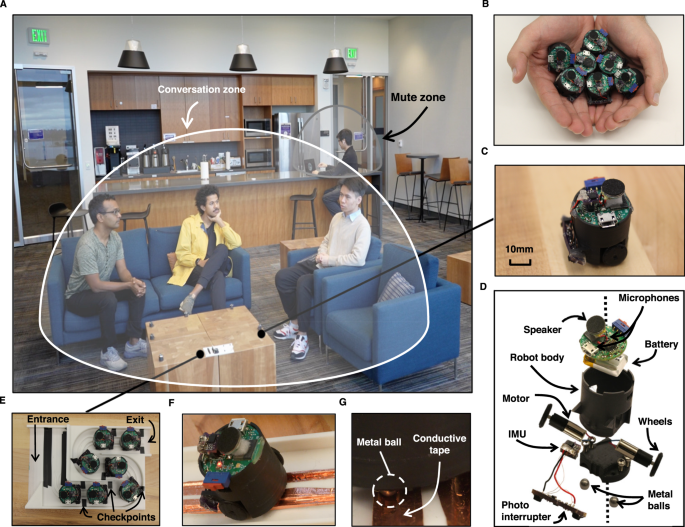

・ UW が、複数の発話者の位置を特定してそれらの発話を分離する、「音響制御ロボットスウォーム」による形状変化型スマートスピーカーシステムを開発。

・ 仮想会議室ではミュートを使用して複数人による同時発話を回避できるが、賑やかな喫茶店で隣のテーブルの音をボタン一つで遮断することはできない。混雑した部屋の特定の場所の発話者一人のみを分離して音声を特定・制御することは、カメラからの視覚的な合図のない場合には特に困難である。

・ 新システムは、自己展開型マイクを使用して室内を発話ゾーンに分割し、発話者の位置を個別に追跡する。深層学習アルゴリズムが特定の場所でのミュートや、似通った声の発話者らが隣接する場合でも同時の発話を分離する。

・ 各スピーカーのサイズは約 1 インチ(2.54cm)。充電ステーションに自動で帰還し、環境を自由に往来して自動配置する。会議室の中央マイクの代わりとして、室内音声のより良い制御が可能となる。

・ 従来のロボットスウォームでは、オーバーヘッドまたはオンデバイスのカメラ、プロジェクターや特殊な表面等を要したが、新システムは音のみの使用によりロボットスウォームを正確に配置できる。

・ 新システムのプロトタイプは、様々なサイズのテーブル上で自動展開する 7 基の小型ロボットで構成。充電器から出発する際に各ロボットが高周波音を放出し、この音とセンサーを使用して障害物を回避し、テーブルから落下せずに移動する。

・ 各ロボットは、互いに可能な限り離れた場所に超高精度で自身を配置することで発話者の区別・特定をより容易にする。現在のスマートスピーカーでは複数のマイクが同一デバイスに搭載されて近接しており、新システムのようなミュートやアクティブゾーンの機能を備えていない。

・ 3~5 人が発話するオフィス、居間や台所での実証試験では、発話者の人数を事前に把握せずに全ての環境で 50cm 以内で発生する異なる声を 90%の確率で識別できた。平均 1.82 秒で 3 秒間の音声を処理し、ライブストリーミングには十分な速度だが、ビデオ電話等のリアルタイム通信には若干遅い。

・ 最終目標は、テーブルに制限されずに室内を自由に動き回れるマイク・ロボットの開発。マイク作動時のライト点滅や、クラウドではなくローカルでの音声処理等のプライバシーを保護する対策もとっている。

・ 本研究には、Moore Inventor Fellow アワードが資金を提供した。

URL: https://www.washington.edu/news/2023/09/21/shape-changing-smart-speaker-ai-noise-canceling-alexa-robot/

<NEDO海外技術情報より>

関連情報

Nature Communications 掲載論文(フルテキスト)

Creating speech zones with self-distributing acoustic swarms

URL: https://www.nature.com/articles/s41467-023-40869-8

Abstract

Imagine being in a crowded room with a cacophony of speakers and having the ability to focus on or remove speech from a specific 2D region. This would require understanding and manipulating an acoustic scene, isolating each speaker, and associating a 2D spatial context with each constituent speech. However, separating speech from a large number of concurrent speakers in a room into individual streams and identifying their precise 2D locations is challenging, even for the human brain. Here, we present the first acoustic swarm that demonstrates cooperative navigation with centimeter-resolution using sound, eliminating the need for cameras or external infrastructure. Our acoustic swarm forms a self-distributing wireless microphone array, which, along with our attention-based neural network framework, lets us separate and localize concurrent human speakers in the 2D space, enabling speech zones. Our evaluations showed that the acoustic swarm could localize and separate 3-5 concurrent speech sources in real-world unseen reverberant environments with median and 90-percentile 2D errors of 15 cm and 50 cm, respectively. Our system enables applications like mute zones (parts of the room where sounds are muted), active zones (regions where sounds are captured), multi-conversation separation and location-aware interaction.