2024-12-03 ジョージア工科大学

<関連情報>

- https://research.gatech.edu/multipurpose-model-enhances-forecasting-across-epidemics-energy-and-economics

- https://arxiv.org/abs/2311.11413

時空間時系列解析タスクのための大規模な事前訓練された時系列モデル

Large Pre-trained time series models for cross-domain Time series analysis tasks

Harshavardhan Kamarthi, B. Aditya Prakash

arXive last revised 4 Dec 2024 (this version, v3)

DOI:https://doi.org/10.48550/arXiv.2311.11413

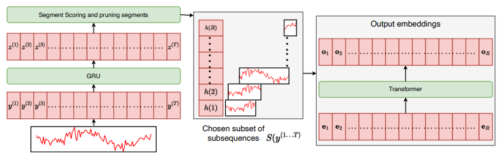

Large pre-trained models have been vital in recent advancements in domains like language and vision, making model training for individual downstream tasks more efficient and provide superior performance. However, tackling time-series analysis tasks usually involves designing and training a separate model from scratch leveraging training data and domain expertise specific to the task. We tackle a significant challenge for pre-training a foundational time-series model from multi-domain time-series datasets: extracting semantically useful tokenized inputs to the model across heterogenous time-series from different domains. We propose Large Pre-trained Time-series Models (LPTM) that introduces a novel method of adaptive segmentation that automatically identifies optimal dataset-specific segmentation strategy during pre-training. This enables LPTM to perform similar to or better than domain-specific state-of-art model when fine-tuned to different downstream time-series analysis tasks and under zero-shot settings. LPTM achieves superior forecasting and time-series classification results taking up to 40% less data and 50% less training time compared to state-of-art baselines. Code: this http URL