2024-11-08 タフツ大学

<関連情報>

- https://now.tufts.edu/2024/11/08/ai-needs-work-its-conversation-game

- https://arxiv.org/abs/2410.16044

大規模言語モデルは何を話すべきか知っているが、いつ話すべきかは知らない Large Language Models Know What To Say But Not When To Speak

Muhammad Umair, Vasanth Sarathy, JP de Ruiter

ArXiv Submitted on 21 Oct 2024

DOI:https://doi.org/10.48550/arXiv.2410.16044

Abstract

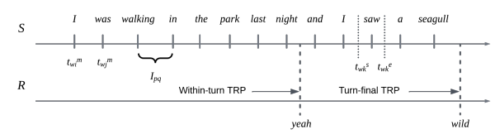

Turn-taking is a fundamental mechanism in human communication that ensures smooth and coherent verbal interactions. Recent advances in Large Language Models (LLMs) have motivated their use in improving the turn-taking capabilities of Spoken Dialogue Systems (SDS), such as their ability to respond at appropriate times. However, existing models often struggle to predict opportunities for speaking — called Transition Relevance Places (TRPs) — in natural, unscripted conversations, focusing only on turn-final TRPs and not within-turn TRPs. To address these limitations, we introduce a novel dataset of participant-labeled within-turn TRPs and use it to evaluate the performance of state-of-the-art LLMs in predicting opportunities for speaking. Our experiments reveal the current limitations of LLMs in modeling unscripted spoken interactions, highlighting areas for improvement and paving the way for more naturalistic dialogue systems.