2024-05-09 アメリカ合衆国・オハイオ州立大学

・ オハイオ州立大学が、制御システムの単純化や消費電力の低減を実現する、次世代のリザバーコンピューティングをベースとしたアルゴリズムを開発。

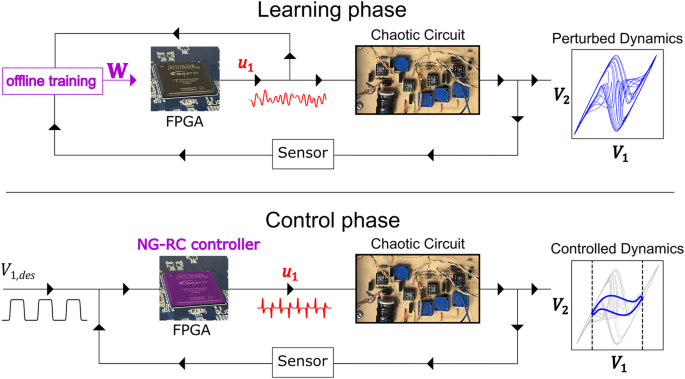

・ 機械学習ツールでカオス的な挙動を示す電子回路のデジタルツイン (デジタルモデル) を作ることで、その挙動の予測やその情報を利用した制御が可能となっている。

・ サーモスタットやクルーズコントロール等の日常的な機器で利用されるリニアコントローラーは、シンプルなルールを使ってシステムを目標値へと誘導する。例えば、サーモスタットでは、このルールを使うことで、現在の温度と望ましい温度の差から空間の冷暖房の度合を決定している。

・ しかし、これらのアルゴリズムは非常に単純であるため、自動運転車等の高度なデバイスの複雑な挙動を示すシステムを制御することが難しい。このようなシステムは、最良の動作のための最適な制御アルゴリズムの学習に複雑なネットワークを使用する、機械学習ベースのコントローラーに依存している。

・ リザバーコンピューティングの機械学習で訓練される新デジタルツインは、安価なコンピューターチップに適合するほどコンパクトでインターネット接続も不要。コントローラーの効率性と性能を最適化し、消費電力も低減させ、経時的に変化するシステム動作の学習に非常に優れる。自動運転車に加え、心拍への迅速な適応が必須の心臓モニター等の動的システムの対応に特に適する。

・ 新デジタルツインに複雑な制御タスクを実行させ、その結果を従前の制御技術によるものと比較した結果、新アプローチはタスクの実行においてより高い精度を達成し、従来の機械学習コントローラーに比べて計算の複雑さが大幅に低減したことを確認した。

・ 精度が大幅に向上した一方で、従来のリニアコントローラーよりも電力を多く消費するが、さらなる強化を通じて市販の機械学習ベースのコントローラーよりも動作時間が長く、より効率的なモデルが実現可能と考える。

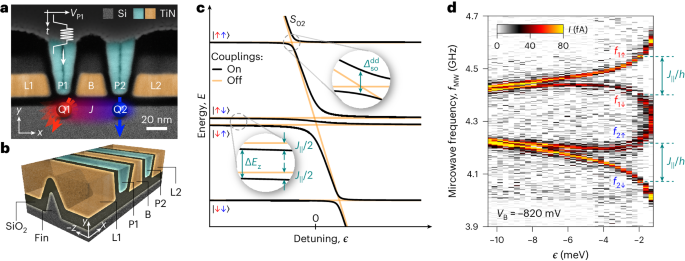

・ 省エネ型のアルゴリズムは、コンピューター・AI の利用やデータセンターの需要に伴う電力消費量の増大や、カーボンンフットプリントの課題にも対処するもの。今後は量子情報処理等に向けたモデルの訓練を予定。このようなアルゴリズムの産業界やエンジニアリングへの浸透を期待する。

・ 本研究は米国空軍科学研究局(AFOSR)が支援した。

URL: https://news.osu.edu/new-machine-learning-algorithm-promises-advances-in-computing/

<NEDO海外技術情報より>

関連情報

Nature Communications 掲載論文(フルテキスト)

Controlling chaos using edge computing hardware

URL: https://www.nature.com/articles/s41467-024-48133-3

Abstract

Machine learning provides a data-driven approach for creating a digital twin of a system – a digital model used to predict the system behavior. Having an accurate digital twin can drive many applications, such as controlling autonomous systems. Often, the size, weight, and power consumption of the digital twin or related controller must be minimized, ideally realized on embedded computing hardware that can operate without a cloud-computing connection. Here, we show that a nonlinear controller based on next-generation reservoir computing can tackle a difficult control problem: controlling a chaotic system to an arbitrary time-dependent state. The model is accurate, yet it is small enough to be evaluated on a field-programmable gate array typically found in embedded devices. Furthermore, the model only requires 25.0 ±7.0 nJ per evaluation, well below other algorithms, even without systematic power optimization. Our work represents the first step in deploying efficient machine learning algorithms to the computing “edge.”