2023-12-08 スイス連邦工科大学ローザンヌ校(EPFL)

AI-generated (DALL-E 3) conceptual image depicting light waves passing through a physical system. © 2023 EPFL/LWE CC-BY-SA 4.0

AI-generated (DALL-E 3) conceptual image depicting light waves passing through a physical system. © 2023 EPFL/LWE CC-BY-SA 4.0

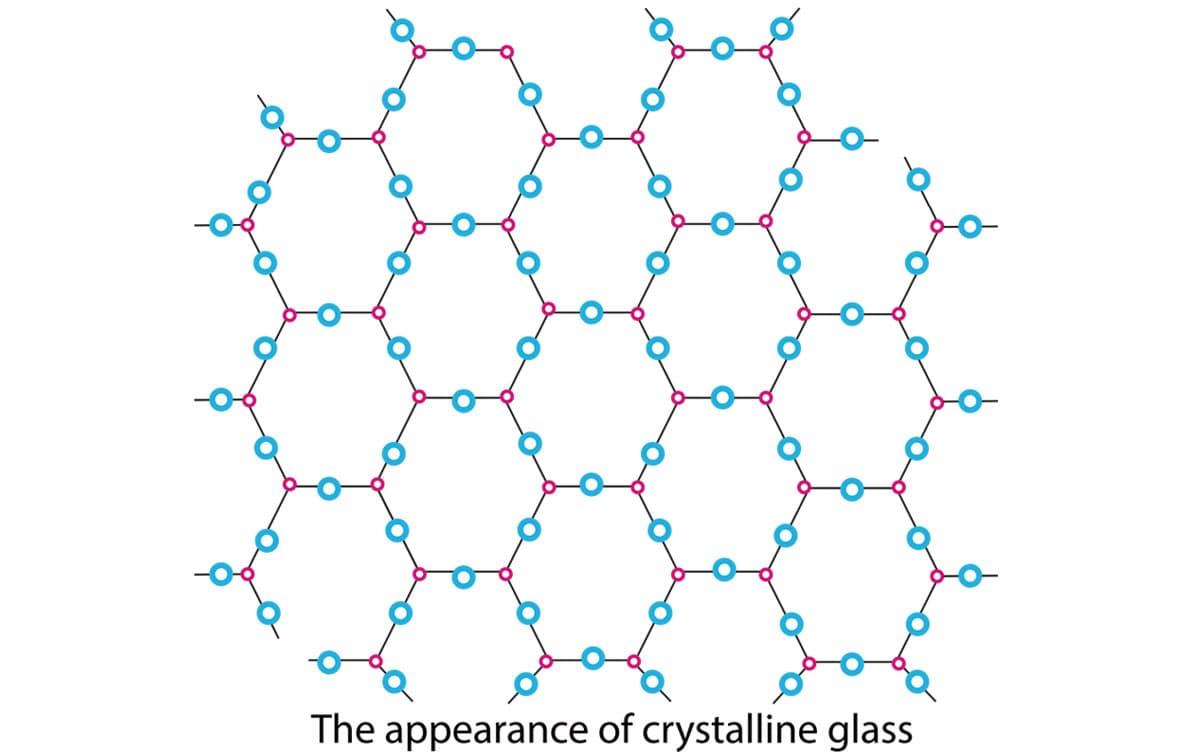

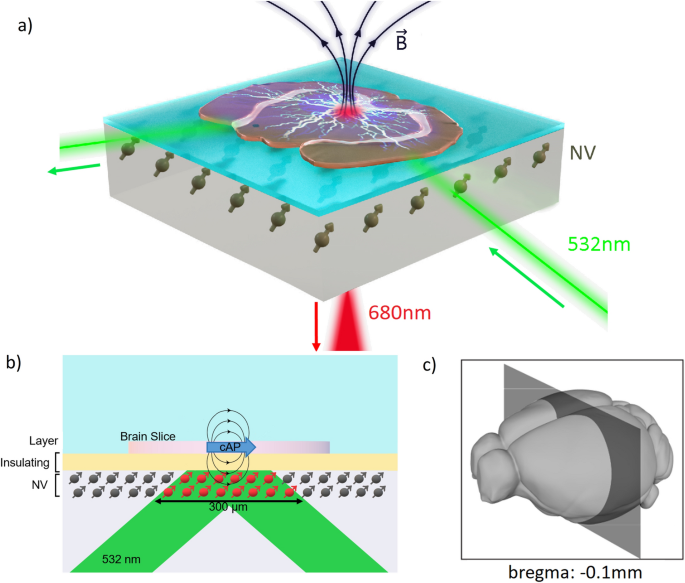

◆EPFLの研究者は、物理的な深層ニューラルネットワークの代替手段として、音波、光波、マイクロ波を利用する物理システムをトレーニングするための効率的なアルゴリズムを開発しました。通常のバックプロパゲーションの代わりに物理システムを使用し、これにより電力使用が削減され、デジタルツインが不要になり、人間の学習により適した手法が提案されています。

<関連情報>

- https://actu.epfl.ch/news/training-algorithm-breaks-barriers-to-deep-physi-4/

- https://www.science.org/doi/10.1126/science.adi8474

物理ニューラルネットワークのバックプロパゲーション不要トレーニング Backpropagation-free training of deep physical neural networks

Ali Momeni,Babak Rahmani,Matthieu Malléjac,Philipp del Hougne,and Romain Fleury

Science Published:23 Nov 2023

DOI:https://doi.org/10.1126/science.adi8474

Abstract

Recent successes in deep learning for vision and natural language processing are attributed to larger models but come with energy consumption and scalability issues. Current training of digital deep learning models primarily relies on backpropagation that is unsuitable for physical implementation. Here, we proposed a simple deep neural network architecture augmented by a physical local learning (PhyLL) algorithm, enabling supervised and unsupervised training of deep physical neural networks, without detailed knowledge of the nonlinear physical layer’s properties. We trained diverse wave-based physical neural networks in vowel and image classification experiments, showcasing our approach’s universality. Our method shows advantages over other hardware-aware training schemes by improving training speed, enhancing robustness, and reducing power consumption by eliminating the need for system modelling and thus decreasing digital computation.