2022-10-04 アメリカ合衆国・マサチューセッツ工科大学(MIT)

・ MIT と MIT-IBM Watson AI Lab が、スマートフォンやセンサー等のエッジデバイスでのニューラルネットワーク(NN)機械学習(ML)モデルの継続的な学習を可能にする、アルゴリズムとシステムの協調設計フレームワークを開発。

・ IoT での膨大な数のコネクテッドデバイスのベースとなるマイクロコントローラーは、安価で低エネルギーだがメモリ容量に限りがあり、OS を持たない。エッジデバイスでの AI モデルの利用には、データセンターのパワフルなコンピューターの使用が不可避であり、高コストに加え、中央のサーバーへのユーザーデータの送信によるプライバシーリスクの懸念もある。

・ 新フレームワークでは、アップデート対象の最も重要なウェイト(ニューロン間の結合強度)を訓練毎

に特定するアルゴリズムのスパースアップデート(sparse update)と、訓練の量子化とウェイトの簡易化

により訓練・推論のメモリを低減し、ウェイト勾配間の比率を調整して訓練の量子化による精度の低下を回避する、量子化を考慮したスケーリング(quantization-aware scaling: QAS)のアルゴリズムを利用

する。

・ また、OS を持たないシンプルなマイクロコントローラーでこれらのアルゴリズムの動作を可能にする

小規模訓練エンジン(tiny training engine)が、エッジデバイスでモデルを利用する前に、コンパイルの段階で作業をより多く完了させるよう訓練プロセスの順番を変更する。

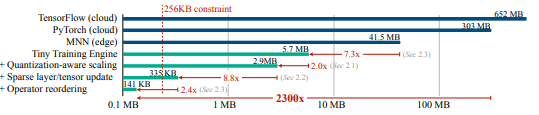

・ このようなフレームワークにより、わずか 157KB のメモリによるマイクロコントローラーでの ML モデルの訓練が可能に。軽めの訓練用に設計した他の技術では 300~600MB を要する。

・新フレームワークによる、画像中の人物を特定するコンピュータービジョンモデルの訓練の試験では、僅か 10 分間の訓練によるタスクの完了を学習。他の技術の 20 倍超の速度でのモデルの訓練を実証した。

・ コンピュータービジョンモデルでの成功を踏まえ、言語モデルや時系列データ等への適用を試みる予定。また、精度を維持したモデルの縮小化によるカーボンフットプリントの削減も目指す。

・ 本研究には、米国立科学財団(NSF)、MIT-IBM Waston AI Lab、MIT AI Hardware Program、

Amazon、Intel、Qualcomm、Ford Motor Company および Google が資金を提供した。

URL: https://news.mit.edu/2022/machine-learning-edge-microcontroller-1004

<NEDO海外技術情報より>

関連情報

Conference on Neural Information Processing Systems 発表論文(フルテキスト)

On-Device Training Under 256KB Memory

URL: https://arxiv.org/pdf/2206.15472.pdf

Abstract

On-device training enables the model to adapt to new data collected from the sensors by fine-tuning a pre-trained model. Users can benefit from customized AI models without having to transfer the data to the cloud, protecting the privacy. However, the training memory consumption is prohibitive for IoT devices that have tiny memory resources. We propose an algorithm-system co-design framework to make on-device training possible with only 256KB of memory. On-device training faces two unique challenges: (1) the quantized graphs of neural networks are hard to optimize due to low bit-precision and the lack of normalization; (2) the limited hardware resource does not allow full back-propagation. To cope with the optimization difficulty, we propose Quantization-Aware Scaling to calibrate the gradient scales and stabilize 8-bit quantized training. To reduce the memory footprint, we propose Sparse Update to skip the gradient computation of less important layers and sub-tensors. The algorithm innovation is implemented by a lightweight training system, Tiny Training Engine, which prunes the backward computation graph to support sparse updates and offload the runtime auto-differentiation to compile time. Our framework is the first solution to enable tiny on-device training of convolutional neural networks under 256KB SRAM and 1MB Flash without auxiliary memory, using less than 1/1000 of the memory of PyTorch and TensorFlow while matching the accuracy on tinyML application VWW [20]. Our study enables IoT devices not only to perform inference but also to continuously adapt to new data for on-device lifelong learning. A video demo can be found here.