2025-12-03 スイス連邦工科大学ローザンヌ校(EPFL)

<関連情報>

- https://actu.epfl.ch/news/secrets-of-human-behavior-come-to-light-in-a-very/

- https://openreview.net/forum?id=FVIPADDm4E&referrer=%5Bthe%20profile%20of%20Silvestro%20Micera%5D(%2Fprofile%3Fid%3D~Silvestro_Micera1)

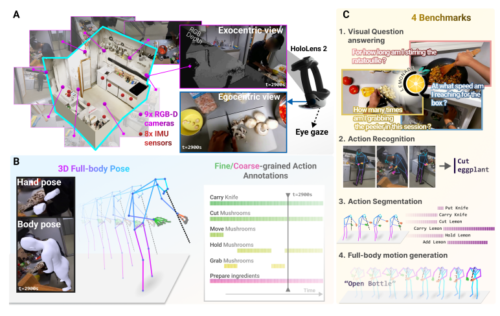

EPFL-Smart-Kitchen: 動画言語モデルにおける動作理解に挑戦するためのエゴ・エキソ・マルチモーダル・データセット EPFL-Smart-Kitchen: An Ego-Exo Multi-Modal Dataset for Challenging Action and Motion Understanding in Video-Language Models

Andy Bonnett, Haozhe Qi, Franklin Leong, Matea Tashkovska, Mahdi Rad, Solaiman Shokur, Friedhelm Hummel, Silvestro Micera, Marc Pollefeys, Alexander Mathis

The Thirty-ninth Annual Conference on Neural Information Processing Systems Datasets and Benchmarks Track (2025) Published: 19 Sept 2025

Abstract

Understanding behavior requires datasets that capture humans while carrying out complex tasks. The kitchen is an excellent environment for assessing human motor and cognitive function, as many complex actions are naturally exhibited in kitchens from chopping to cleaning. Here, we introduce the EPFL-Smart-Kitchen-30 dataset, collected in a noninvasive motion capture platform inside a kitchen environment. Nine static RGB-D cameras, inertial measurement units (IMUs) and one head-mounted HoloLens~2 headset were used to capture 3D hand, body, and eye movements. The EPFL-Smart-Kitchen-30 dataset is a multi-view action dataset with synchronized exocentric, egocentric, depth, IMUs, eye gaze, body and hand kinematics spanning 29.7 hours of 16 subjects cooking four different recipes. Action sequences were densely annotated with 33.78 action segments per minute. Leveraging this multi-modal dataset, we propose four benchmarks to advance behavior understanding and modeling through 1) a vision-language benchmark, 2) a semantic text-to-motion generation benchmark, 3) a multi-modal action recognition benchmark, 4) a pose-based action segmentation benchmark. We expect the EPFL-Smart-Kitchen-30 dataset to pave the way for better methods as well as insights to understand the nature of ecologically-valid human behavior. Code and data are available at https://amathislab.github.io/EPFL-Smart-Kitchen