2025-11-17 ノースカロライナ州立大学(NC State)

<関連情報>

- https://news.ncsu.edu/2025/11/first-defense-against-cryptanalytic-attacks/

- https://arxiv.org/abs/2509.16546

- https://arxiv.org/pdf/2509.16546

防御のための訓練:暗号解読ニューラルネットワークパラメータ抽出攻撃に対する最初の防御 Train to Defend: First Defense Against Cryptanalytic Neural Network Parameter Extraction Attacks

Ashley Kurian, Aydin Aysu

arXiv Submitted on 20 Sep 2025

DOI:https://doi.org/10.48550/arXiv.2509.16546

Abstract

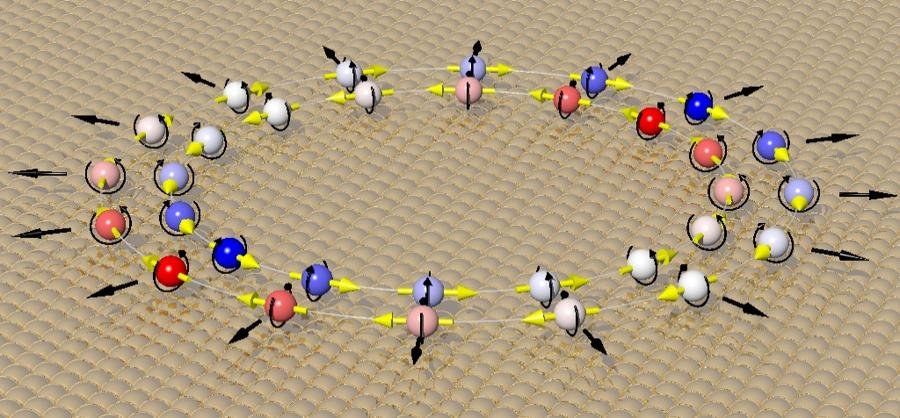

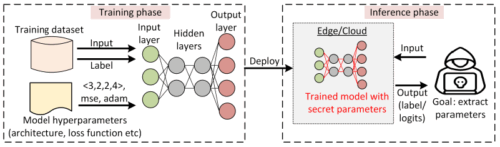

Neural networks are valuable intellectual property due to the significant computational cost, expert labor, and proprietary data involved in their development. Consequently, protecting their parameters is critical not only for maintaining a competitive advantage but also for enhancing the model’s security and privacy. Prior works have demonstrated the growing capability of cryptanalytic attacks to scale to deeper models. In this paper, we present the first defense mechanism against cryptanalytic parameter extraction attacks. Our key insight is to eliminate the neuron uniqueness necessary for these attacks to succeed. We achieve this by a novel, extraction-aware training method. Specifically, we augment the standard loss function with an additional regularization term that minimizes the distance between neuron weights within a layer. Therefore, the proposed defense has zero area-delay overhead during inference. We evaluate the effectiveness of our approach in mitigating extraction attacks while analyzing the model accuracy across different architectures and datasets. When re-trained with the same model architecture, the results show that our defense incurs a marginal accuracy change of less than 1% with the modified loss function. Moreover, we present a theoretical framework to quantify the success probability of the attack. When tested comprehensively with prior attack settings, our defense demonstrated empirical success for sustained periods of extraction, whereas unprotected networks are extracted between 14 minutes to 4 hours.