2021-05-27 アメリカ合衆国・コロンビア大学

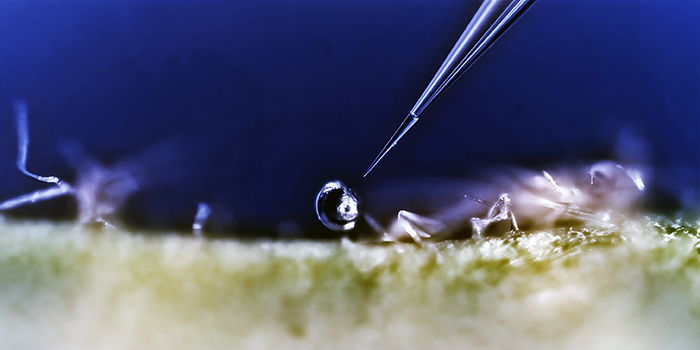

・ コロンビア大学が、AI による学習を通じて人間の表情を適切に模倣するロボット、EVA を開発。

・ プロジェクトの第一段階として、数年前に EVA の機械部分の作製を開始。顔を青く塗った米国の演劇集団の Blue Man Group に似た EVA では、ケーブルやモーターによる人工的な「筋肉」が顔面の特定の箇所で作動し、人間の顔の皮膚や骨の様々な箇所に付随した 42 種類以上の微細な筋肉の動きを模倣する。

・ その結果、EVA は怒り、嫌気、恐れ、喜び、悲しみ、驚きの 6 種類の基本的な感情の表情に加え、微妙な差違のある表情も提示できる。

・ EVA の狭小な頭部に効率的かつシームレスに統合する複雑な形状のパーツを 3D プリントし、コンパクトなシステムを作製した。

・ 本研究では、プロジェクトの第二段階として、EVA の顔の動きを促す AI プログラムを開発。複雑な社会的環境で起こる非反復的な身体挙動は、人間の活動の中でも自動化が最も困難なもの。EVA による表情作成のプロセスは極めて複雑で決まったルールによる制御が不可能なため、深層学習のニューラルネットワーク(NN)により EVA の頭脳を構築した。

・ EVA の頭脳では、まず、機械的筋肉の複雑なシステムで特定の表情を作る方法を学習し、次に、人間の表情を読み取って、自らが提示する表情を決定する。

・ EVA が作る一連のランダムな表情の動画を EVA に見せることで、EVA の NN に筋肉の動きと動画上の表情の組合せを学習させ、EVA に自己の顔の基本的な働き(自己像)を理解させた。

・ 次に、EVA のビデオカメラが捉えた人間の表情の画像と自己像を 2 番目のネットワークを使用してマッチさせた。多少の改善や反復を経て、EVA はカメラに写った人間の顔の表情を読み取り、それを模倣する能力を獲得した。

・ これらは研究室での実証であり、人間による表情を通じたコミュニケーションの複雑さの達成にはほど遠いものの、人間の身体言語に反応できるロボットは、職場や病院等において有用と考える。様々な形で日常生活に浸透しているロボットとの信頼関係の構築の重要性は高まっている。

・ 本研究は、米国立科学財団(NSF)が支援した。

URL: https://www.engineering.columbia.edu/press-release/the-robot-smiled-back

<NEDO海外技術情報より>

(関連情報)

arXiv.org (コーネル大学図書館)公開論文(フルテキスト)

Smile Like You Mean It: Driving Animatronic Robotic Face with Learned Models

URL: https://arxiv.org/abs/2105.12724

Abstract

Ability to generate intelligent and generalizable facial expressions is essential for building human-like social robots. At present, progress in this field is hindered by the fact that each facial expression needs to be programmed by humans. In order to adapt robot behavior in real time to different situations that arise when interacting with human subjects, robots need to be able to train themselves without requiring human labels, as well as make fast action decisions and generalize the acquired knowledge to diverse and new contexts. We addressed this challenge by designing a physical animatronic robotic face with soft skin and by developing a vision-based self-supervised learning framework for facial mimicry. Our algorithm does not require any knowledge of the robot’s kinematic model, camera calibration or predefined expression set. By decomposing the learning process into a generative model and an inverse model, our framework can be trained using a single motor babbling dataset. Comprehensive evaluations show that our method enables accurate and diverse face mimicry across diverse human subjects.