科学的AIの「ブラックボックス」は、200年前の手法には勝てない。 Scientific AI’s ‘black box’ is no match for 200-year-old method

2023-02-13 ライス大学

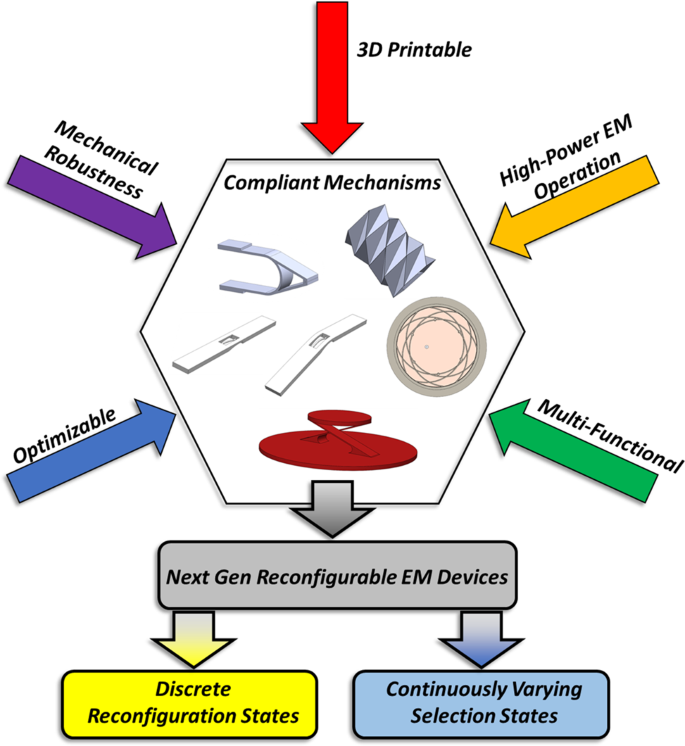

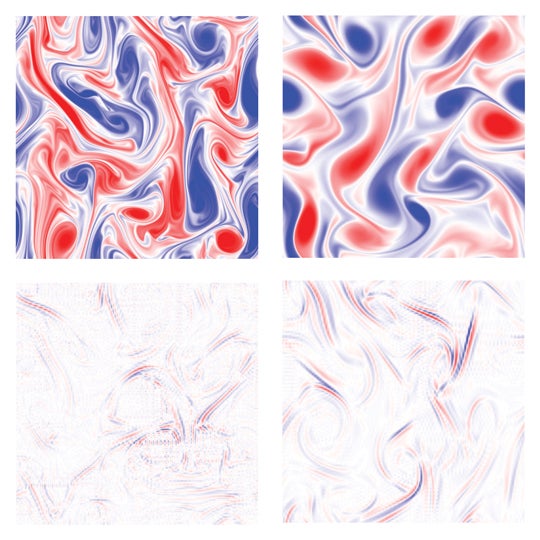

Rice University researchers trained a form of artificial intelligence called a deep learning neural network to recognize complex flows of air or water and predict how flows will change over time. This visual illustrates the substantial differences in the scale of features the model is shown during training (top) and the features it learns to recognize (bottom) to make its predictions. (Image courtesy of P. Hassanzadeh/Rice University)

◆ライス大学の機械工学研究者によるこの発見は、米国科学アカデミー紀要の姉妹誌であるPNAS Nexusに発表されたオープンアクセス研究に記載されています。

◆”ディープニューラルネットワークは悪名高く理解が難しく、しばしば “ブラックボックス “とみなされます。「これは、ディープニューラルネットワークを科学的な用途に使用する際の大きな懸念事項の1つです。もう1つは、汎化性です。これらのネットワークは、訓練されたシステムとは異なるシステムに対しては機能しないのです。

◆Hassanzadehは、彼のチームが論文で提示した分析フレームワークは、”ブラックボックスを開き、ネットワークが何を学習し、なぜ学習したかを理解するために内部を見ることができ、また、それを学習したシステムの物理に接続することができます。”と言っています。

◆1820年代に提案されたフーリエ解析は、物理学者や数学者が空間と時間の周波数パターンを特定するために好んで使う手法。

◆Hassanzadeh氏のチームはまず、完全に訓練されたディープラーニングモデルの方程式に対してフーリエ変換を実行した。モデルの約100万個のパラメータはそれぞれ乗算器のような役割を果たし、モデルの計算中に方程式内の特定の演算に多かれ少なかれ重みを加える。未訓練のモデルでは、パラメータはランダムな値を持っている。これらのパラメータは、学習中に調整され、アルゴリズムが徐々に学習して、学習ケースにおける既知の結果に近い予測値を導き出すように磨かれていく。モデルのパラメータは、4万個の5×5行列(カーネル)で構成されている。

◆”そして、そうしてみると、ニューラルネットワークが学習しているのは、ローパスフィルター、ハイパスフィルター、ガボールフィルターの組み合わせであることが、ポンと出てきたのです。”と、彼は言いました。

◆”これの素晴らしいところは、ニューラルネットワークが魔法を使っていないことです “とハッサンザデは言いました。とハッサンザデは言います。「何もおかしなことはしていません。物理学者や数学者がやろうとしていたことを、実際にやっているのです」。もちろん、ニューラルネットの力がなければ、これらのフィルタを正しく組み合わせる方法はわかりませんでした。でも、物理学者にこの研究のことを話すと、とても喜ばれます。なぜなら、彼らは「ああ! こういうのがあるんだ」と、わかってくれるからです。これがニューラルネットワークが学習したものなんだ。なるほどね』って。

<関連情報>

- https://news.rice.edu/news/2023/scientific-ais-black-box-no-match-200-year-old-method

- https://academic.oup.com/pnasnexus/advance-article/doi/10.1093/pnasnexus/pgad015/6998042

データ駆動型乱流モデリングにおける伝達学習の物理的説明 Explaining the physics of transfer learning in data-driven turbulence modeling

Adam Subel, Yifei Guan, Ashesh Chattopadhyay, Pedram Hassanzadeh

PNAS Nexus Published:23 January 2023

DOI:https://doi.org/10.1093/pnasnexus/pgad015

Abstract

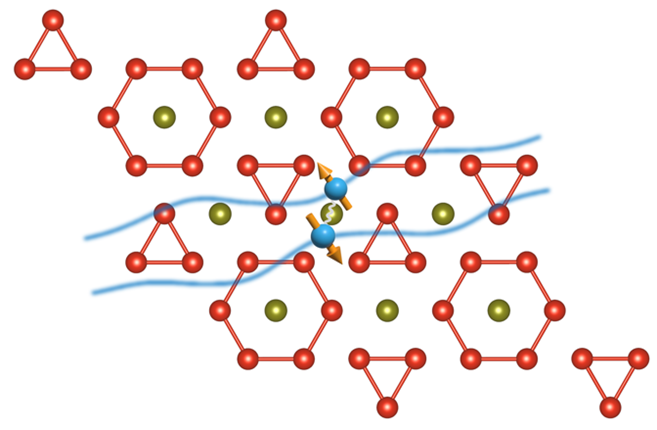

Transfer learning (TL), which enables neural networks (NNs) to generalize out-of-distribution via targeted re-training, is becoming a powerful tool in scientific machine learning (ML) applications such as weather/climate prediction and turbulence modeling. Effective TL requires knowing 1) how to re-train NNs? and 2) what physics are learned during TL? Here, we present novel analyses and a framework addressing (1)-(2) for a broad range of multi-scale, nonlinear, dynamical systems. Our approach combines spectral (e.g., Fourier) analyses of such systems with spectral analyses of convolutional NNs, revealing physical connections between the systems and what the NN learns (a combination of low-, high-, band-pass filters and Gabor filters). Integrating these analyses, we introduce a general framework that identifies the best re-training procedure for a given problem based on physics and NN theory. As test case, we explain the physics of TL in subgrid-scale modeling of several setups of 2D turbulence. Furthermore, these analyses show that in these cases, the shallowest convolution layers are the best to re-train, which is consistent with our physics-guided framework but is against the common wisdom guiding TL in the ML literature. Our work provides a new avenue for optimal and explainable TL, and a step toward fully explainable NNs, for wide-ranging applications in science and engineering, such as climate change modeling.