2025-03-10 ニューヨーク大学 (NYU)

<関連情報>

- https://www.nyu.edu/about/news-publications/news/2025/march/can-ai-tell-us-if-those-zoom-calls-are-flowing-smoothly–new-stu.html

- https://ieeexplore.ieee.org/document/10889480

マルチモーダル機械学習により、ビデオ会議の円滑さと楽しさを予測することができる Multimodal Machine Learning Can Predict Videoconference Fluidity and Enjoyment

Andrew Chang; Viswadruth Akkaraju; Ray McFadden Cogliano; David Poeppel; Dustin Freeman

ICASSP 2025 – 2025 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) Date of Conference 06-11 April 2025

DOI:https://doi.org/10.1109/ICASSP49660.2025.10889480

Abstract

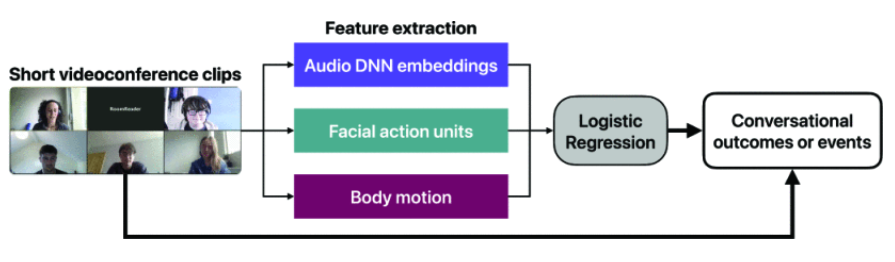

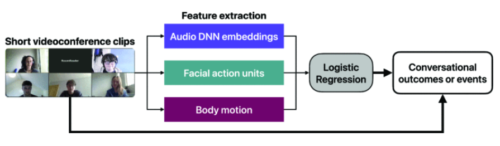

Videoconferencing is now a frequent mode of communication in both professional and informal settings, yet it often lacks the fluidity and enjoyment of in-person conversation. This study leverages multimodal machine learning to predict moments of negative experience in videoconferencing. We sampled thousands of short clips from the RoomReader corpus [1], extracting audio embeddings, facial actions, and body motion features to train models for identifying low conversational fluidity, low enjoyment, and classifying conversational events (backchanneling, interruption, or gap). Our best models achieved an ROC-AUC of up to 0.87 on hold-out videoconference sessions, with domain-general audio features proving most critical. This work demonstrates that multimodal audio-video signals can effectively predict high-level subjective conversational outcomes. In addition, this is a contribution to research on videoconferencing user experience by showing that multimodal machine learning can be used to identify rare moments of negative user experience for further study or mitigation.