(NTU Singapore scientists develop Artificial Intelligence system for high precision recognition of hand gestures)

2020/8/13 シンガポール・南洋(ナンヤン)理工大学(NTU)

・ NTU と豪・シドニー工科大学(UTS)が、より正確で効率的にハンドジェスチャーを認識する、コンピュータービジョンと皮膚の様なウェアラブルセンサーを組合せた AI システムを開発。

・ AI システムによるハンドジェスチャー認識は過去 10 年間で進展し、高精度の手術用ロボット、健康モニタリング機器やゲーム機で採用されている。開発初期は視覚情報のみを利用したが、ウェアラブルセンサーからの情報の統合(「データフュージョン(融合)」のアプローチ)により向上している。ウェアラブルセンサーは、「体性感覚(somatosensory)」として知られる皮膚の感知能力の一つを再現する。

・ しかし、センサーサイズや装着の不具合、視界外のオブジェクトや照明の弱さの影響でウェアラブルセンサーから得られるデータの品質が劣り、ジェスチャー認識の精度が制限される。また、ビジュアル(画像)とセンサリー(感覚)の両データは個別に処理してから統合する必要があり、非効率で反応時間の遅れにつながる。

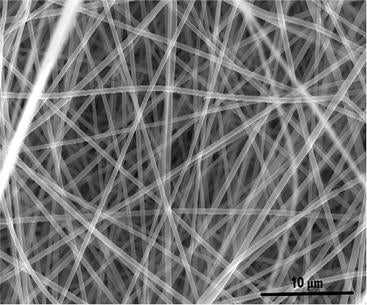

・ これらの課題に対処するため、「バイオインスパイアード(生体から得た着想による)」なデータ融合システムを設計。人間の皮膚のような伸縮性を備えた単層カーボンナノチューブ製の歪みセンサーと、人間の脳が皮膚感覚と視覚を同時に処理するような AI のアプローチを利用する。皮膚に貼り付ける透明な同歪みセンサーはカメラの画像では不可視で、ハンドジェスチャーから高信頼性の感覚データを獲得する。

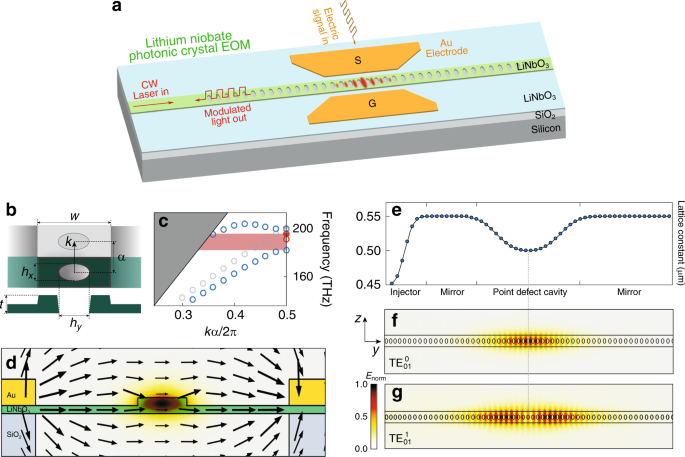

・ 同データ融合システムでは、初期視覚情報を処理する機械学習の畳み込みニューラルネットワーク、初期皮膚感覚情報を処理する多層ニューラルネットワーク、そして視覚情報と皮膚感覚情報を融合するスパースニューラルネットワークの 3 種類のニューラルネットワーク技術を組合せた。

・ 同 AI システムの概念実証としてハンドジェスチャーで制御したロボットに迷路を案内する試験では、視覚ベースの認識システムによる認識エラー6 個に比べ、ゼロエラーで通り抜けに成功。また、ノイズや弱い照明等の不利な条件下の試験でも高精度を維持した。

・ 同 AI システム技術は、スマートなワーキングプレースでのロボット遠隔操作や、高齢者用ロボットスーツ等の様々なアプリケーションが考えられる。エンターテイメントやリハビリテーション等の高精度認識と制御が不可欠な分野で利用できる、同システムをベースとした VR と AR システムの開発を検討中。

URL: https://media.ntu.edu.sg/NewsReleases/Pages/newsdetail.aspx?news=57dcda7a-bc5d-45c1-ab5b-a8143ffb83df

<NEDO海外技術情報より>

(関連情報)

Nature Electronics 掲載論文(アブストラクトのみ:全文は有料)

Gesture recognition using a bioinspired learning architecture that integrates visual data with

somatosensory data from stretchable sensors

URL: https://www.nature.com/articles/s41928-020-0422-z

Abstract

Gesture recognition using machine-learning methods is valuable in the development of advanced cybernetics, robotics and healthcare systems, and typically relies on images or videos. To improve recognition accuracy, such visual data can be combined with data from other sensors, but this approach, which is termed data fusion, is limited by the quality of the sensor data and the incompatibility of the datasets. Here, we report a bioinspired data fusion architecture that can perform human gesture recognition by integrating visual data with somatosensory data from skin-like stretchable strain sensors made from single-walled carbon nanotubes. The learning architecture uses a convolutional neural network for visual processing and then implements a sparse neural network for sensor data fusion and recognition at the feature level. Our approach can achieve a recognition accuracy of 100% and maintain recognition accuracy in non-ideal conditions where images are noisy and under- or over-exposed. We also show that our architecture can be used for robot navigation via hand gestures, with an error of 1.7% under normal illumination and 3.3% in the dark.