2024-11-07 ミシガン大学

<関連情報>

- https://news.umich.edu/up-to-30-of-the-power-used-to-train-ai-is-wasted-heres-how-to-fix-it/

- https://arxiv.org/abs/2312.06902

大規模モデル学習におけるエネルギーの膨張を抑える Reducing Energy Bloat in Large Model Training

Jae-Won Chung, Yile Gu, Insu Jang, Luoxi Meng, Nikhil Bansal, Mosharaf Chowdhury

arXiv ast revised 23 Sep 2024 (this version, v3)

DOI:https://doi.org/10.48550/arXiv.2312.06902

Abstract

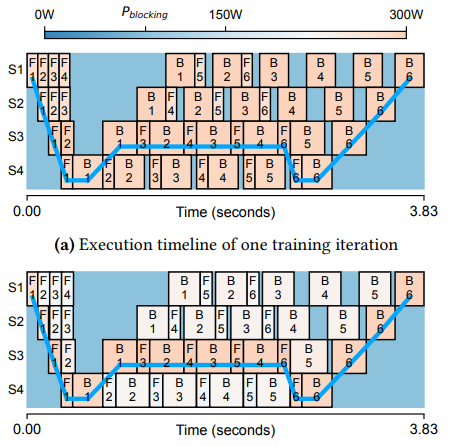

Training large AI models on numerous GPUs consumes a massive amount of energy, making power delivery one of the largest limiting factors in building and operating datacenters for AI workloads. However, we observe that not all energy consumed during training directly contributes to end-to-end throughput; a significant portion can be removed without slowing down training. We call this portion energy bloat.

In this work, we identify two independent sources of energy bloat in large model training and propose Perseus, a training system that mitigates both. To do this, Perseus obtains the time–energy tradeoff frontier of a large model training job using an efficient graph cut-based algorithm, and schedules computation energy consumption across time to reduce both types of energy bloat. Evaluation on large models, including GPT-3 and Bloom, shows that Perseus reduces the energy consumption of large model training by up to 30% without any throughput loss or hardware modification.