2022-12-20 アメリカ合衆国・マサチューセッツ工科大学(MIT)

・ MIT、MIT Lincoln Laboratory および Nokia Corporation が、エッジデバイスと機械学習(machine learning: ML)モデル間の演算処理のレイテンシ(通信遅延)を大幅に低減する、ニューラル・ネットワーク(NN)アーキテクチャの「Netcast」を開発。

・ 他技術の 100 倍を超えるエネルギー効率の向上や、サーバーへのユーザーデータ送信不要によるセキュリティー強化の効果を提供。インターネットで 1 ミリ秒毎に長編映画を送信する速さでデータ送信・演算を実行する。

・ より少ないエネルギー消費での自動運転車のリアルタイム操作判断や、スマートホームデバイスとのレイテンシーフリー通信、また、セルラーネットワークでのライブビデオ処理や、地球から数百万マイル離れた宇宙探査機での高速画像分類を可能にする。

・ 結合したノード(人工ニューロン)の階層を利用してパターン認識やタスクを実行する ML モデルのNN には、数十億もの重みのパラメータ(入力したデータを変換する数値)が含まれ、これらをメモリに格納する必要がある。

・ また、データ変換プロセスでの膨大な量の代数演算では、エネルギーを大量に消費する。メモリから重みを移動させて演算を実行するプロセスは、処理速度とエネルギー効率を制限する主な要因の一つとなっている。

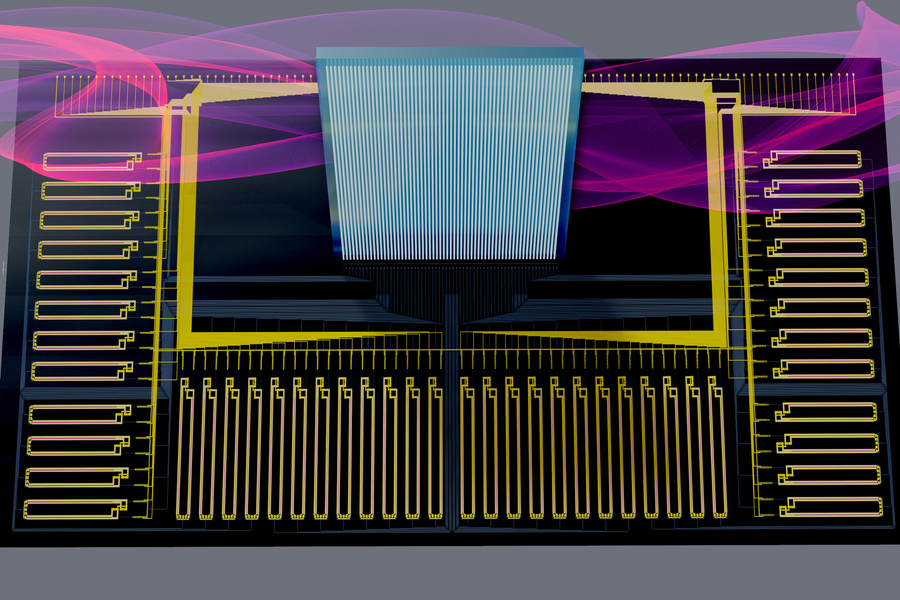

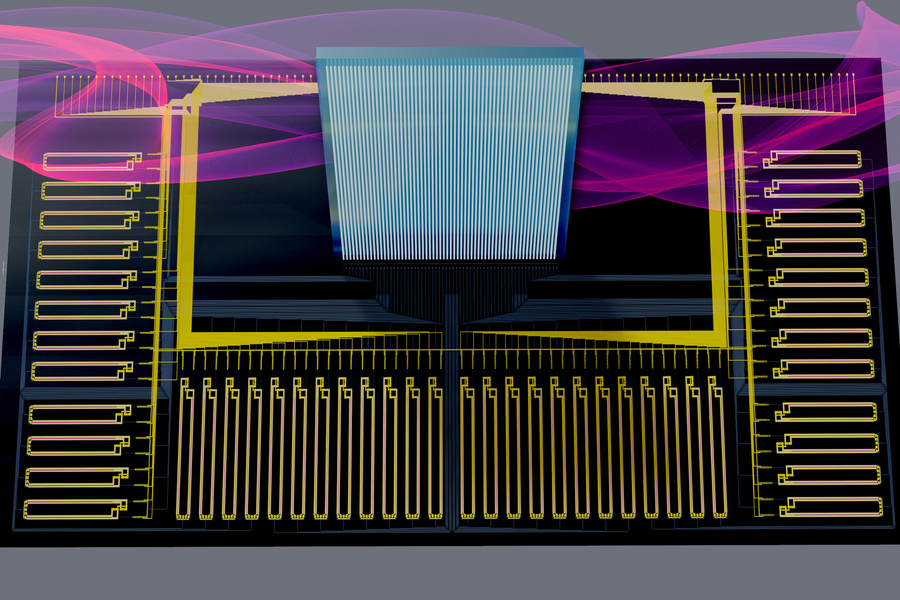

・ 「Netcast」では、重みデータを中央サーバーのメモリに格納し、親指サイズのチップのスマート・トランシーバーがそれらを読み出して光波に書き込む。トランシーバーは重みを電気信号として受け取り、ビットでエンコードされた重みのデータをレーザーのオン(1)・オフ(0)切り替えで変換する。これらの光波を光ファイバーネットワークを通じてエッジデバイスに周期的に送信する。

・ 光波がエッジデバイスに到着すると、エッジデバイスの入力データ(センサー情報等)が重みにエンコードされ、マッハツェンダ変調器が超高速アナログ演算を実行し、続いてレシーバに個々の波長が送信され、演算結果を測定する。

・ 86km の光ファイバーでの重み送信試験の結果、画像分類では 98.7%の、数字認識では 98.8%の精度での ML の高速作動を確認。今後はスマート・トランシーバーチップの性能向上と、靴箱大のレシーバーのチップサイズへの小型化を目指す。

・ 本研究には、NTT Research、米国立科学財団(NSF)、米国空軍科学研究局(AFOSR)、空軍研究所(AFRL)および陸軍研究局(ARO)が資金を提供した。

URL: https://news.mit.edu/2022/optics-deep-learning-computations-1020

<NEDO海外技術情報より>

関連情報

Science 掲載論文(アブストラクトのみ:全文は有料)

Delocalized photonic deep learning on the internet’s edge

URL: https://www.science.org/doi/10.1126/science.abq8271

Learning on the edge

Smart devices such as cell phones and sensors are low-power electronics operating on the edge of the internet. Although they are increasingly more powerful, they cannot perform complex machine learning tasks locally. Instead, such devices offload these tasks to the cloud, where they are performed by factory-sized servers in data centers, creating issues related to large power consumption, latency, and data privacy. Sludds et al. introduce an edge-computing architecture called NetCast that makes use of the strengths of photonics and electronics. In this method, smart transceivers periodically broadcast the weights of commonly used deep neural networks. The architecture allows low-power edge devices with minimal memory and processing to compute at teraflop rates otherwise reserved for high-power cloud computers. —ISO

Abstract

Advanced machine learning models are currently impossible to run on edge devices such as smart sensors and unmanned aerial vehicles owing to constraints on power, processing, and memory. We introduce an approach to machine learning inference based on delocalized analog processing across networks. In this approach, named Netcast, cloud-based “smart transceivers” stream weight data to edge devices, enabling ultraefficient photonic inference. We demonstrate image recognition at ultralow optical energy of 40 attojoules per multiply (<1 photon per multiply) at 98.8% (93%) classification accuracy. We reproduce this performance in a Boston-area field trial over 86 kilometers of deployed optical fiber, wavelength multiplexed over 3 terahertz of optical bandwidth. Netcast allows milliwatt-class edge devices with minimal memory and processing to compute at teraFLOPS rates reserved for high-power (>100 watts) cloud computers.