2024-05-28 スイス連邦・チューリッヒ大学(UZH)

・ UZH が、自動運転車の安全性を飛躍的に向上させる、バイオに着想したカメラと人工知能(AI)を組み合わせたコンピューター・ビジョンシステムを開発。

・ 一部の自動車にはドライバーへの警告や緊急ブレーキの作動機能を備えたカメラシステムが搭載されているが、自動運転車での使用にはその速度や信頼性の大幅な改善が必要となる。

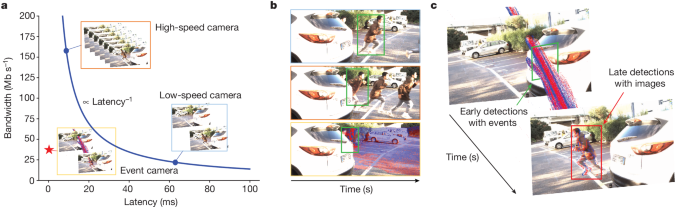

・ 現行の自動車の運転支援用カメラは、一定の間隔でスナップショットを撮るフレームベースのものが多く、1 秒毎に 30~50 フレーム(fps)を捉え、人工ニューラルネットワークを訓練して歩行者等を認識できるようするが、2 枚のフレーム間の 20~30 ミリ秒のブラインドタイムが発生する。安全性の確保にフレームレートを上げるとリアルタイム処理のデータ量が増加し、より高い計算能力が必要となる。

・ フレームベースの技術に代わるイベントカメラは、人間の目による画像認識の仕組みを模倣するニューロモーフィックカメラとも呼ばれ、スマートピクセルが高速の挙動を検出して情報を記録する。フレーム間のブラインドスポットが消えることでより速く物体を検出するが、動きの遅いものを見落とす可能性があることと、AI アルゴリズムの訓練用のデータへの撮影画像の変換が容易でないことが欠点。

・ 新ビジョンシステムでは、自動車や歩行者の認識を訓練した畳み込みニューラルネットワーク(CNN)が標準的なカメラによる画像(20fps)を処理し、経時変化する 3D データの分析に適した非同期グラフニューラルネットワーク(GNN)がイベントカメラのデータを処理する。

・ イベントカメラのデータは標準カメラによる検出の予測に利用され、カメラの性能を向上させる。5,000fpsのカメラと同じような速さで物体を検出し、標準的な 50fps のカメラと同じような帯域幅を使用する。

・ 自動車市場の最先端のカメラと視覚アルゴリズムとの性能比較試験の結果、新システムではカメラとオンボードコンピューター間のデータ転送量と画像処理に要する計算能力を削減しながら、物体検出の速度を 100 倍高速化することを確認した。

・ 標準カメラの 2 フレーム間の視界に入る物体を効果的に検出し、特に高速下における運転者と交通参加者の安全性をさらに高める。将来的には LiDAR センサーとの統合で機能をさらに強化できる可能性がある。

・ 本研究は、Huawei Zurich、スイス連邦研究能力センター(NCCR)ロボティクスを通じ、スイス国立科学財団(SNSF)および欧州研究会議(ERC)が支援した。

URL: https://www.news.uzh.ch/en/articles/media/2024/Two-Cameras-Plus-AI.html

<NEDO海外技術情報より>

関連情報

Nature 掲載論文(フルテキスト)

Low-latency automotive vision with event cameras

URL: https://www.nature.com/articles/s41586-024-07409-w

Abstract

The computer vision algorithms used currently in advanced driver assistance systems rely on image-based RGB cameras, leading to a critical bandwidth–latency trade-off for delivering safe driving experiences. To address this, event cameras have emerged as alternative vision sensors. Event cameras measure the changes in intensity asynchronously, offering high temporal resolution and sparsity, markedly reducing bandwidth and latency requirements1. Despite these advantages, event-camera-based algorithms are either highly efficient but lag behind image-based ones in terms of accuracy or sacrifice the sparsity and efficiency of events to achieve comparable results. To overcome this, here we propose a hybrid event- and frame-based object detector that preserves the advantages of each modality and thus does not suffer from this trade-off. Our method exploits the high temporal resolution and sparsity of events and the rich but low temporal resolution information in standard images to generate efficient, high-rate object detections, reducing perceptual and computational latency. We show that the use of a 20 frames per second (fps) RGB camera plus an event camera can achieve the same latency as a 5,000-fps camera with the bandwidth of a 45-fps camera without compromising accuracy. Our approach paves the way for efficient and robust perception in edge-case scenarios by uncovering the potential of event cameras2.