2024-07-11 カリフォルニア大学サンディエゴ校(UCSD)

<関連情報>

- https://today.ucsd.edu/story/learning-dance-moves-could-help-humanoid-robots-work-better-with-humans

- https://arxiv.org/abs/2402.16796

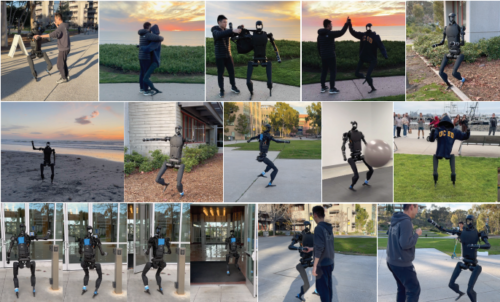

ヒューマノイドロボットのための表現力豊かな全身制御 Expressive Whole-Body Control for Humanoid Robots

Xuxin Cheng, Yandong Ji, Junming Chen, Ruihan Yang, Ge Yang, Xiaolong Wang

arXiv last revised 6 Mar 2024 (this version, v2)

DOI:https://doi.org/10.48550/arXiv.2402.16796

Abstract

Can we enable humanoid robots to generate rich, diverse, and expressive motions in the real world? We propose to learn a whole-body control policy on a human-sized robot to mimic human motions as realistic as possible. To train such a policy, we leverage the large-scale human motion capture data from the graphics community in a Reinforcement Learning framework. However, directly performing imitation learning with the motion capture dataset would not work on the real humanoid robot, given the large gap in degrees of freedom and physical capabilities. Our method Expressive Whole-Body Control (Exbody) tackles this problem by encouraging the upper humanoid body to imitate a reference motion, while relaxing the imitation constraint on its two legs and only requiring them to follow a given velocity robustly. With training in simulation and Sim2Real transfer, our policy can control a humanoid robot to walk in different styles, shake hands with humans, and even dance with a human in the real world. We conduct extensive studies and comparisons on diverse motions in both simulation and the real world to show the effectiveness of our approach.